mysql中的group by高级用法

MySQL中的GROUP BY是数据聚合分析的核心功能,主要用于将结果集按指定列分组,并结合聚合函数进行统计计算。以下从基本语法到高级用法进行详细解析: 一、基本语法与核心功能 1 2 3 4 5 6 S

|

MySQL中的GROUP BY是数据聚合分析的核心功能,主要用于将结果集按指定列分组,并结合聚合函数进行统计计算。以下从基本语法到高级用法进行详细解析: 一、基本语法与核心功能

核心功能:

二、基础用法示例1. 单列分组统计统计每个部门的员工数量和平均工资:

2. 多列组合分组按部门和职位统计员工数量:

3. 与WHERE结合使用仅统计薪资超过2000元的员工部门平均工资:

三、高级特性与扩展1. HAVING子句过滤分组筛选员工数量超过5人的部门:

2. WITH ROLLUP生成汇总行生成部门及职位的薪资小计和总计:

3. GROUP_CONCAT合并列值统计每个用户购买的所有产品(逗号分隔):

4. 按表达式/函数分组按年份统计订单数量:

四、注意事项与常见错误ONLY_FULL_GROUP_BY模式

WHERE与HAVING的区别

性能优化建议

五、经典案例场景1. 按时间维度聚合统计每月的销售总额:

2. 多层级统计分析每个客户每年的订单总金额及平均金额:

3. 数据去重查找重复邮箱的用户:

六、聚合效率优化在MySQL中优化GROUP BY聚合效率需要从索引设计、查询逻辑、执行引擎特性等多维度入手。以下基于最新优化实践和数据库引擎特性,总结9大核心优化策略: 1、索引优化策略复合索引精准匹配分组列 覆盖索引避免回表 利用函数索引应对复杂分组

2、查询设计与执行优化减少分组字段数量与复杂度 分阶段过滤与聚合

内存排序与临时表优化 3、高级优化技术分区表加速大数据处理 物化视图与结果缓存 并行查询(MySQL 8.0+)

4、诊断工具与注意事项• 执行计划分析 • 严格模式规避错误 性能优化对比案例

通过上述策略组合,可系统性解决GROUP BY性能瓶颈。实际应用中建议结合EXPLAIN分析和A/B测试,选择最适合业务场景的优化方案。 七、扩展知识

通过灵活组合这些功能,GROUP BY可满足复杂的数据分析需求。实际应用中需结合索引优化和查询逻辑设计,以提升执行效率。 |

您可能感兴趣的文章 :

-

mysql中的group by高级用法

MySQL中的GROUP BY是数据聚合分析的核心功能,主要用于将结果集按指定列分组,并结合聚合函数进行统计计算。以下从基本语法到高级用法进 -

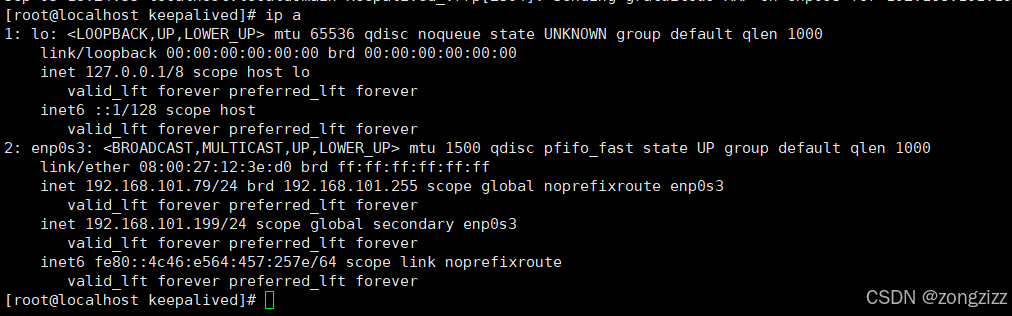

MySQL双主搭建+keepalived高可用的实现

一、测试环境准备 节点1 节点2 IP地址 192.168.101.77 192.168.101.79 MySQL版本 8.0.32 8.0.32 二、主从搭建 1.创建复制用户 节点1执行: 1 2 3 4 mysql CREA -

MySQL使用SHOW PROCESSLIST的实现

1、SHOW PROCESSLIST 显示进程列表 SHOW [FULL] PROCESSLIST 用于查看当前MySQL服务器上的所有运行中的进程列表信息。这个命令可以帮助我们了解哪些 -

MySQL复制三种模式:同步、异步、半同步复制有什

作为数据库领域的快递小哥,MySQL复制技术承担着数据运输的重任。今天我们就来聊聊这个数据世界的快递服务同步复制、异步复制、半同步 -

MySQL逻辑备份的实现方法

MySQL 的逻辑备份指的是使用 SQL 语句备份数据库的结构和数据,而不是直接备份数据库文件。通常使用mysqldump工具进行逻辑备份。 一.mysqld -

navicat连接Mysql数据库报2013错误解决办法

报错信息 Navicat连接mysql报2013错误 2013-Lost connection to MYSQL server at waitting for initial communication packet,system error:0 1、检验Mysql数据库是否安装成 -

MySQL实现索引下推的代码

索引下推(Index Condition Pushdown, 简称ICP)是一种数据库优化技术,旨在减少数据库查询过程中从存储引擎到数据库引擎的数据传输量,从而提 -

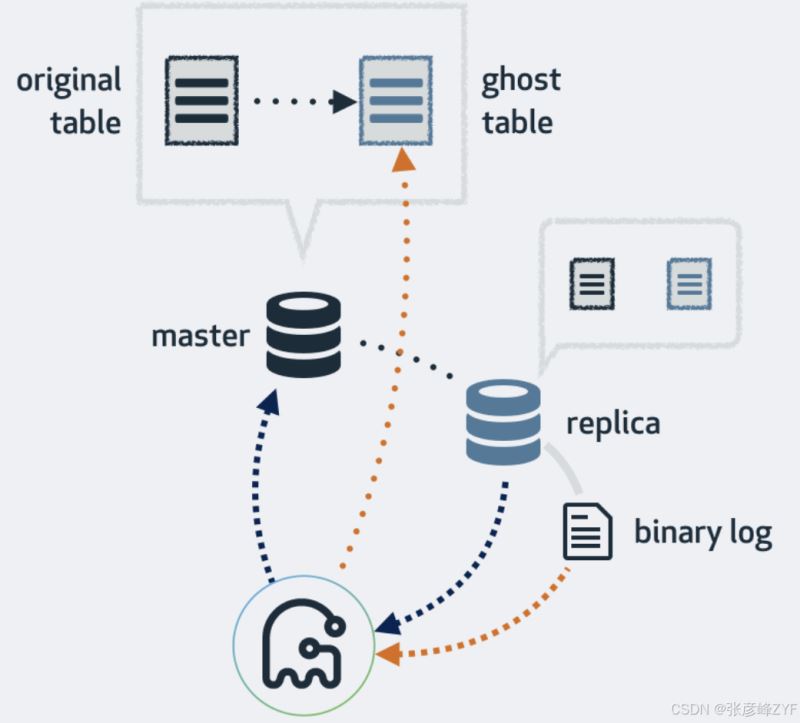

Mysql8主从复制解读(兼容低高版本)

Mysql主从复制 理论知识 主从复制必要前提 主从复制必要的条件: 主库开启binlog日志(设置log-bin参数) 主从server-id不同 从库服务器能连同

-

zabbix监控mysql的实例方法

2021-06-02

-

MySQL时间类型的选择

2021-06-05

-

MySQL数据库基本SQL语句教程之高级操作

2022-06-27

-

MySQL文件权限存在的安全问题和解决方

2024-07-31

-

利用Mysql定时+存储过程创建临时表统

2024-02-19