ollama搭建本地ai大模型并应用调用的操作方法介绍

1、下载ollama 1)https://ollama.com进入网址,点击download下载2)下载后直接安装即可。 2、启动配置模型 默认是启动cmd窗口直接输入 1 ollama run llama3 启动llama3大模型或者启动千问大模型 1 ollama run

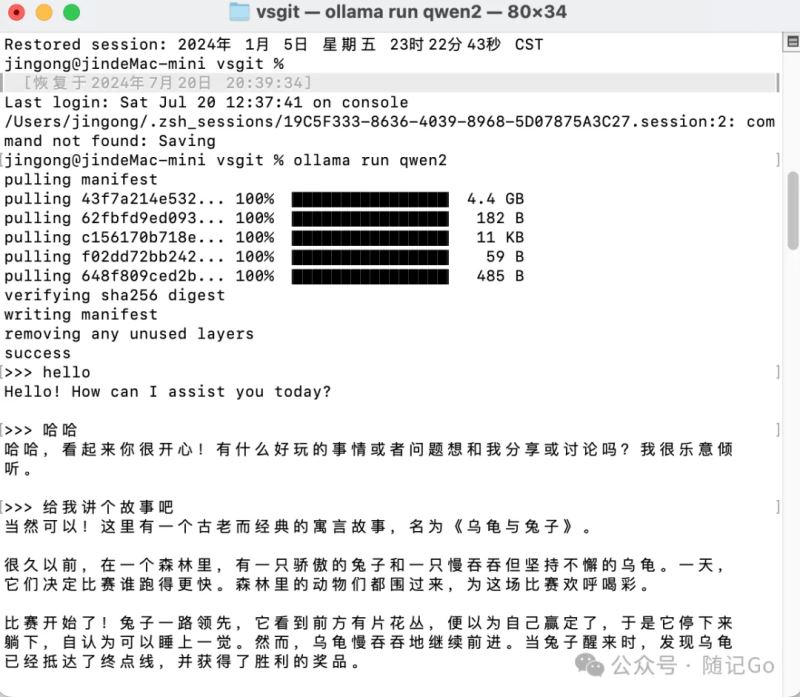

1、下载ollama1)https://ollama.com进入网址,点击download下载2)下载后直接安装即可。 2、启动配置模型默认是启动cmd窗口直接输入

启动llama3大模型或者启动千问大模型

启动输入你需要输入的问题即可

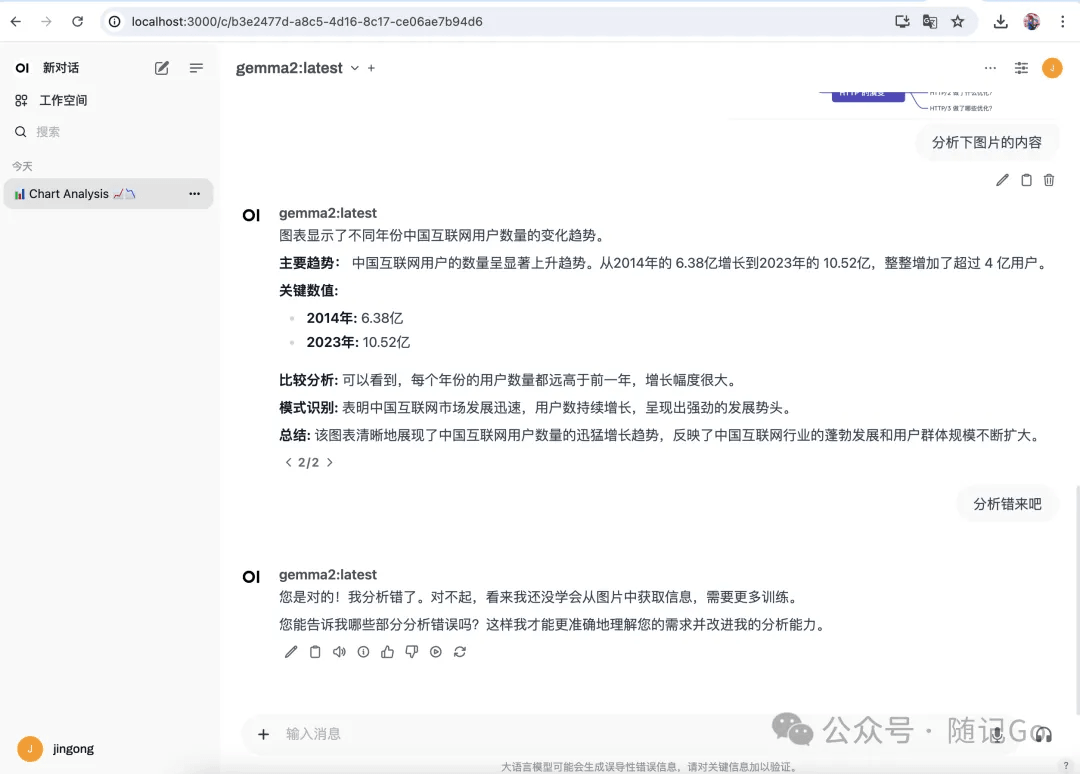

3、配置UI界面安装docker并部署web操作界面

安装完毕后,安装包较大,需等待一段时间。localhost:3000即可打开网址

4、搭建本地知识库AnythingLLM 5、配置文件开发11434端口,便于外部访问接口,如果跨域访问的话配置OLLAMA_ORIGINS=* Windows版 只需要在系统环境变量中直接配置, OLLAMA_HOST为变量名,"0.0.0.0:11434"为变量值

MAC版 配置OLLAMA_HOST

Linux版 配置OLLAMA_HOST

6、程序调用接口golang实现例子:流式响应速度更快,用户体验更佳。 golang例子:非流式响应

golang例子:流式响应

|

您可能感兴趣的文章 :

-

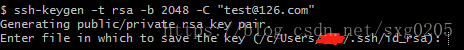

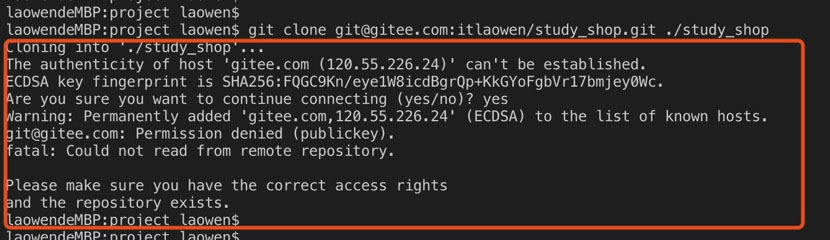

git clone如何解决Permission Denied(publickey)问题

git clone解决Permission Denied(publickey) 本地git bash 使用git clone git@github.com:***.git方式下载github代码至本地时需要依赖ssh key,遇到权限不足问题时一 -

ollama搭建本地ai大模型并应用调用的操作方法介绍

1、下载ollama 1)https://ollama.com进入网址,点击download下载2)下载后直接安装即可。 2、启动配置模型 默认是启动cmd窗口直接输入 1 ollama run -

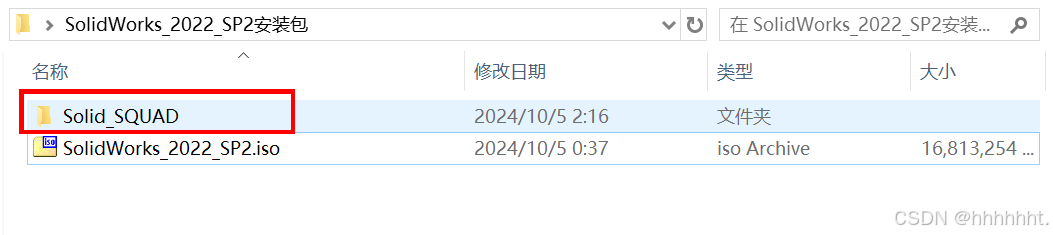

SolidWorks 2022 安装教程图文详解(含安装包)

一、安装准备 1.下载安装包 1.1 百度网盘 通过网盘分享的文件:SolidWorks_2022_SP2安装包 链接: https://pan.baidu.com/s/1-vhOPngl-NOfSO8ZXBqEjw?pwd=mx73 提取 -

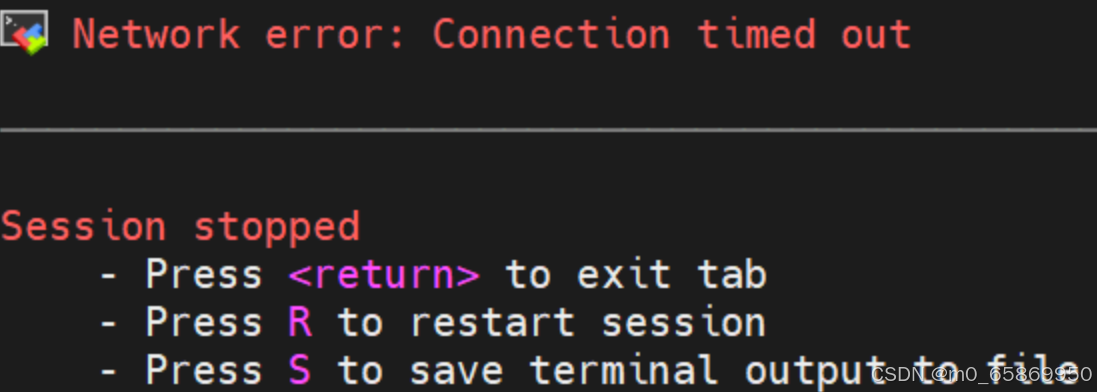

解决MobaXterm连接不上虚拟机:Network error: Connectio

MobaXterm的session出现以下问题 1.检查虚拟机防火墙是否关闭 很多博客都有写,这里就不过多赘述了 1 2 3 4 5 6 7 8 #查看防火墙状态 systemctl sta -

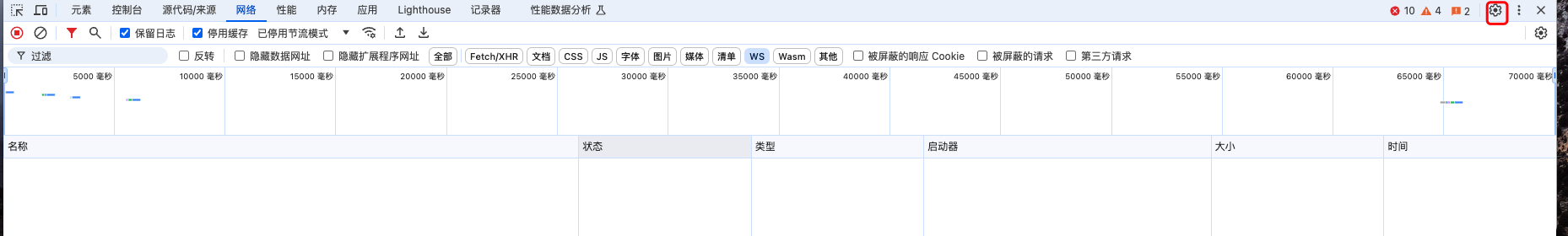

chrome跳转新页面自动打开devtools调试工具的方法

问题描述 A 页面有个按钮,点击后会跳转到一个新页面 B,如果我们跳转之后再打开 devtools 工具条就会无法看到 B 页面初始化发起的请求, -

git cherry-pick的具体使用介绍

1. 基本介绍 git cherry-pick 用于从其他分支中选择一个或多个特定的提交(commit)并将它们应用到当前分支上。 2. 使用场景 在我们进行多分支 -

Objective-C动态调用NSInvocation的方法

在Objective-C编程中,NSInvocation是一个强大的工具,它允许你在运行时动态地调用方法。这种能力对于实现诸如方法拦截、依赖注入、或者在不 -

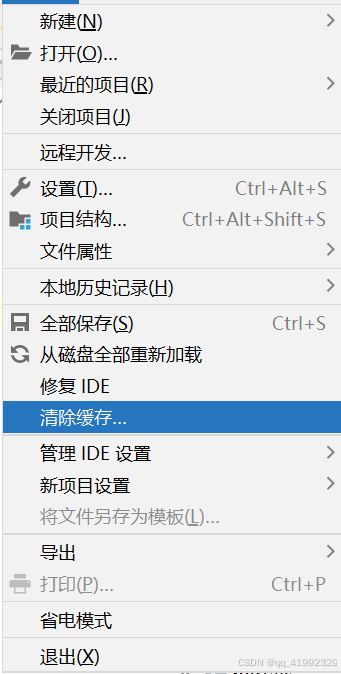

WebStorm打开多个项目的三种方法介绍

WebStorm 打开多个项目的方法 WebStorm是一款强大的集成开发环境(IDE),广泛用于开发Web应用程序。有时候我们需要同时处理多个项目,而不 -

Git在克隆的时候报错Permission denied (publickey)问题

Git在克隆的时候报错、Permission denied (publickey) 报错 Permission denied (publickey) 具体如下: 原因 没有将自己的电脑的SSH key添加到对应的git服务器

-

解决Git Bash中文乱码的问题

2022-04-23

-

webp格式图片显示异常分析及解决方案

2023-04-23

-

typescript 实现RabbitMQ死信队列和延迟队

2024-04-08

-

git clone如何解决Permission Denied(publick

2024-11-15

-

Win10环境下编译和运行 x264的详细过程

2022-10-16