本地搭建DeepSeek-R1、WebUI的完整过程及访问的详细介绍

最近几年,人工智能技术的发展势头愈发强劲。无论是大型语言模型的突破,如美国OpenAI公司开发的ChatGPT,还是中国诸家企业在自主学习系统领域的快速进步,都展现了人工智能技术的前所未

|

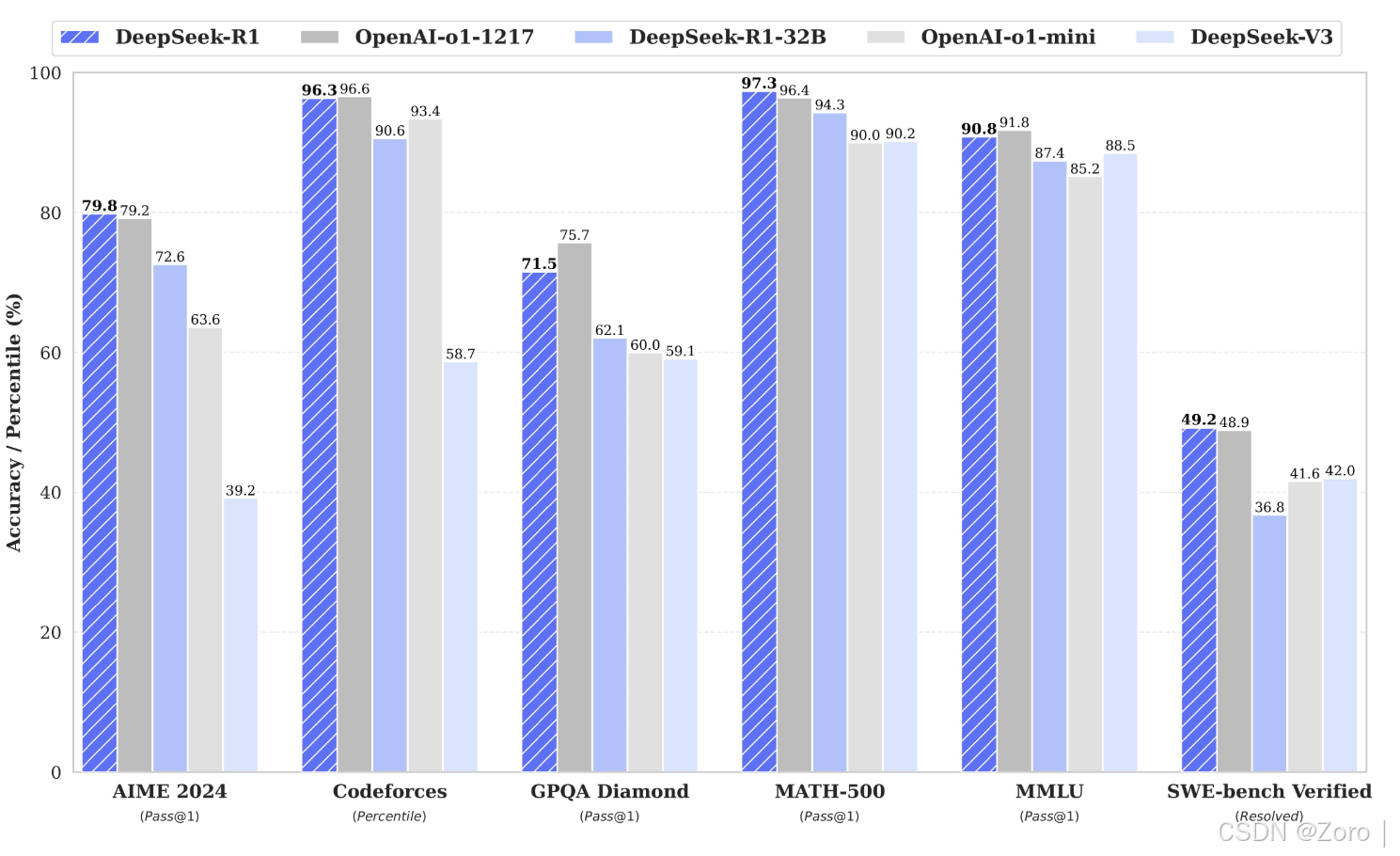

最近几年,人工智能技术的发展势头愈发强劲。无论是大型语言模型的突破,如美国OpenAI公司开发的ChatGPT,还是中国诸家企业在自主学习系统领域的快速进步,都展现了人工智能技术的前所未有的潜力和变革力量。这不仅仅是技术本身的飞速发展,更是人类对知识边界与认知极限的一次深度探索。从自然语言处理到计算机视觉,从强化学习到生成式AI,技术创新层出不穷,为人类社会带来了前所未有的变革。 在这场技术革命中,我们欣喜地看到AI系统能够以接近或超越人类水平的能力,完成复杂的知识推理、多任务处理以及创造性思考。例如,DeepSeek等中国公司开发的智能搜索引擎,不仅在信息检索方面取得了显著进展,还展现出独特的领域适应能力。此外,AI技术的应用已经渗透到各个行业,从医疗、教育到金融,每一个领域都在经历着前所未有的数字化与智能化转型。在这个充满挑战与机遇的时代,我们需要以更加开放和包容的心态,拥抱人工智能带来的变革,同时也要保持对未知未来的一种敬畏与谨慎。 本文旨在详细介绍如何离线搭建DeepSeek-R1,主要为企业级开发使用。另外官方线上环境因火爆的访问量及持续遭受每秒上亿次的Dos恶意请求,导致访问体验感不好的小伙伴也可以进行离线搭建使用。 仅需线上体验的朋友可以直接跳转官网链接。 搭建准备

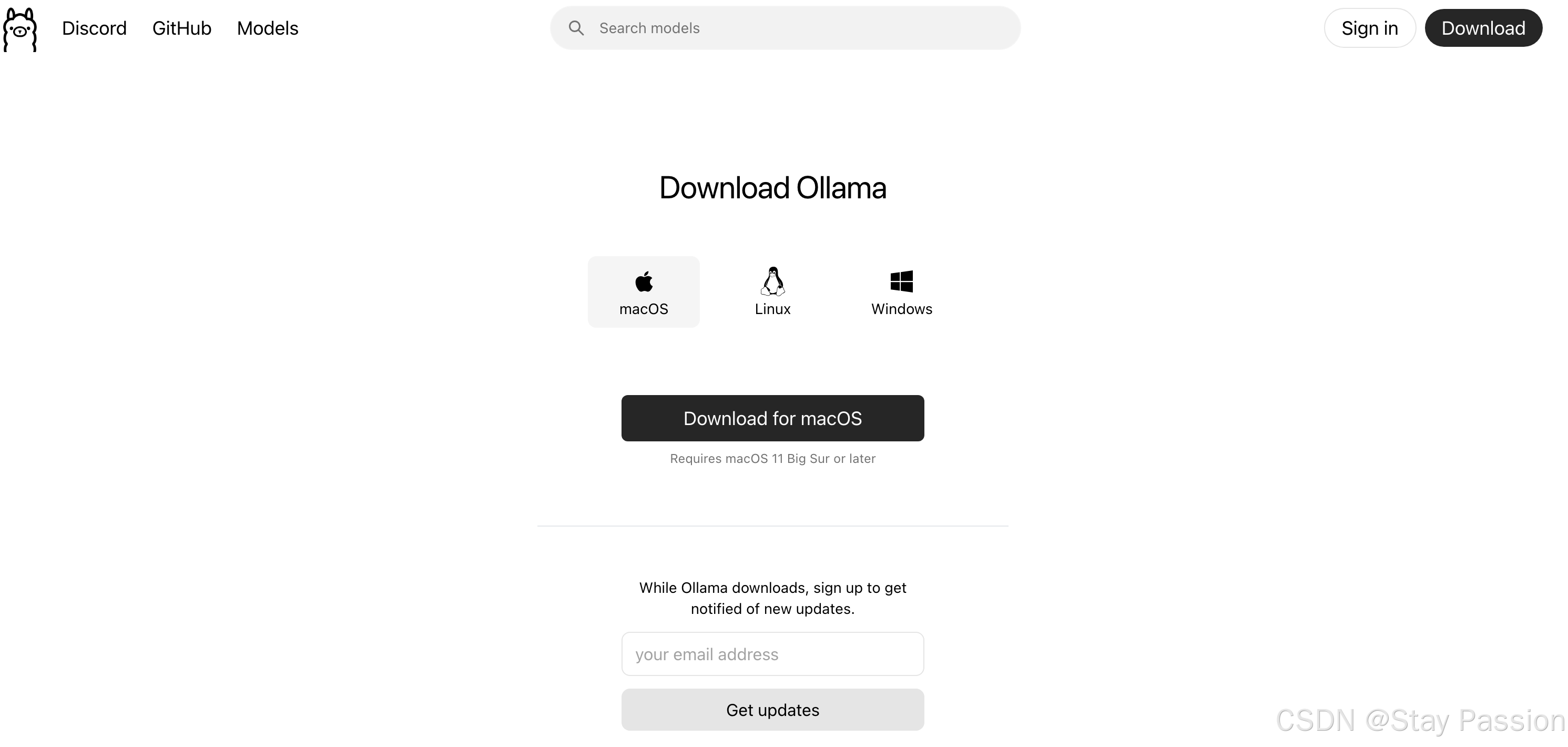

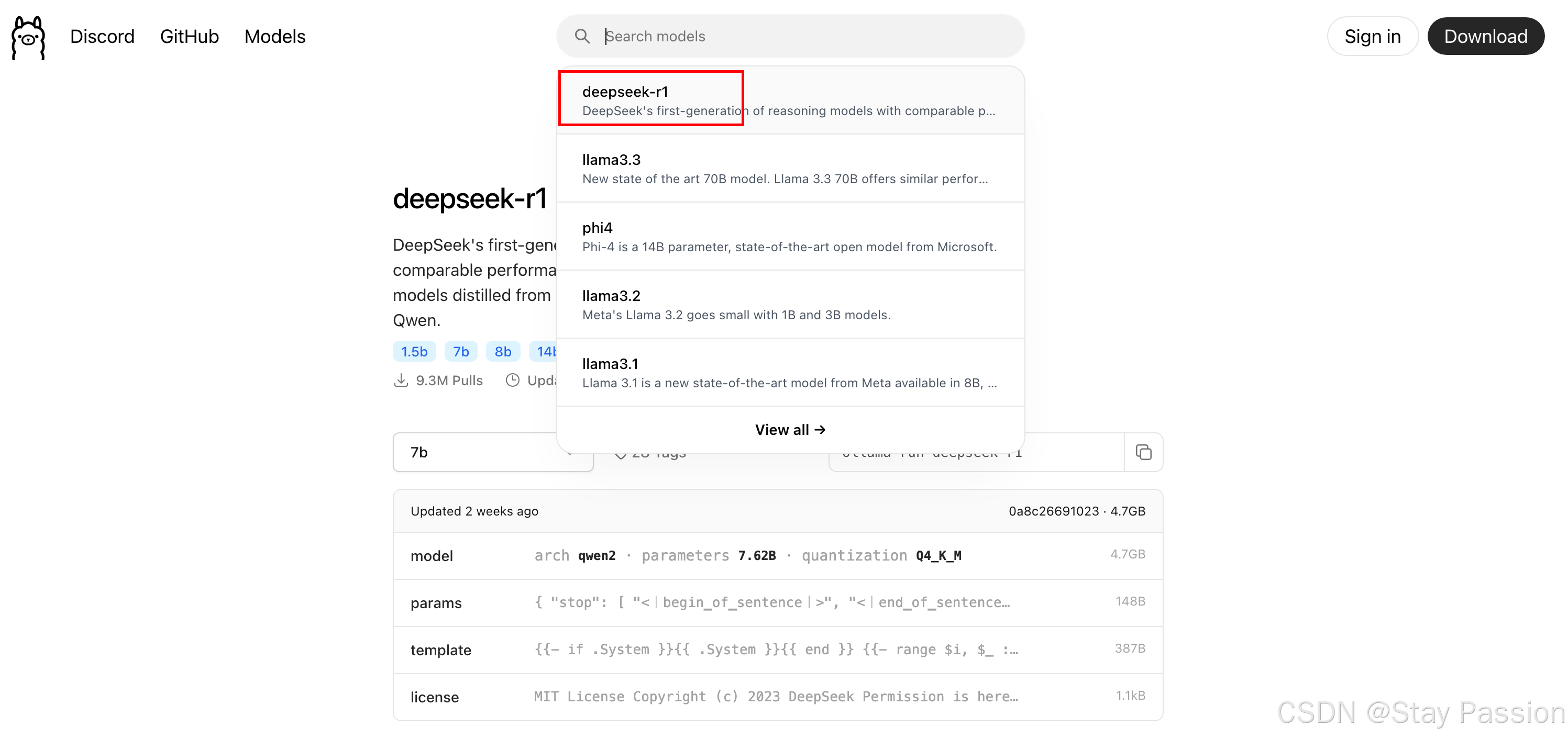

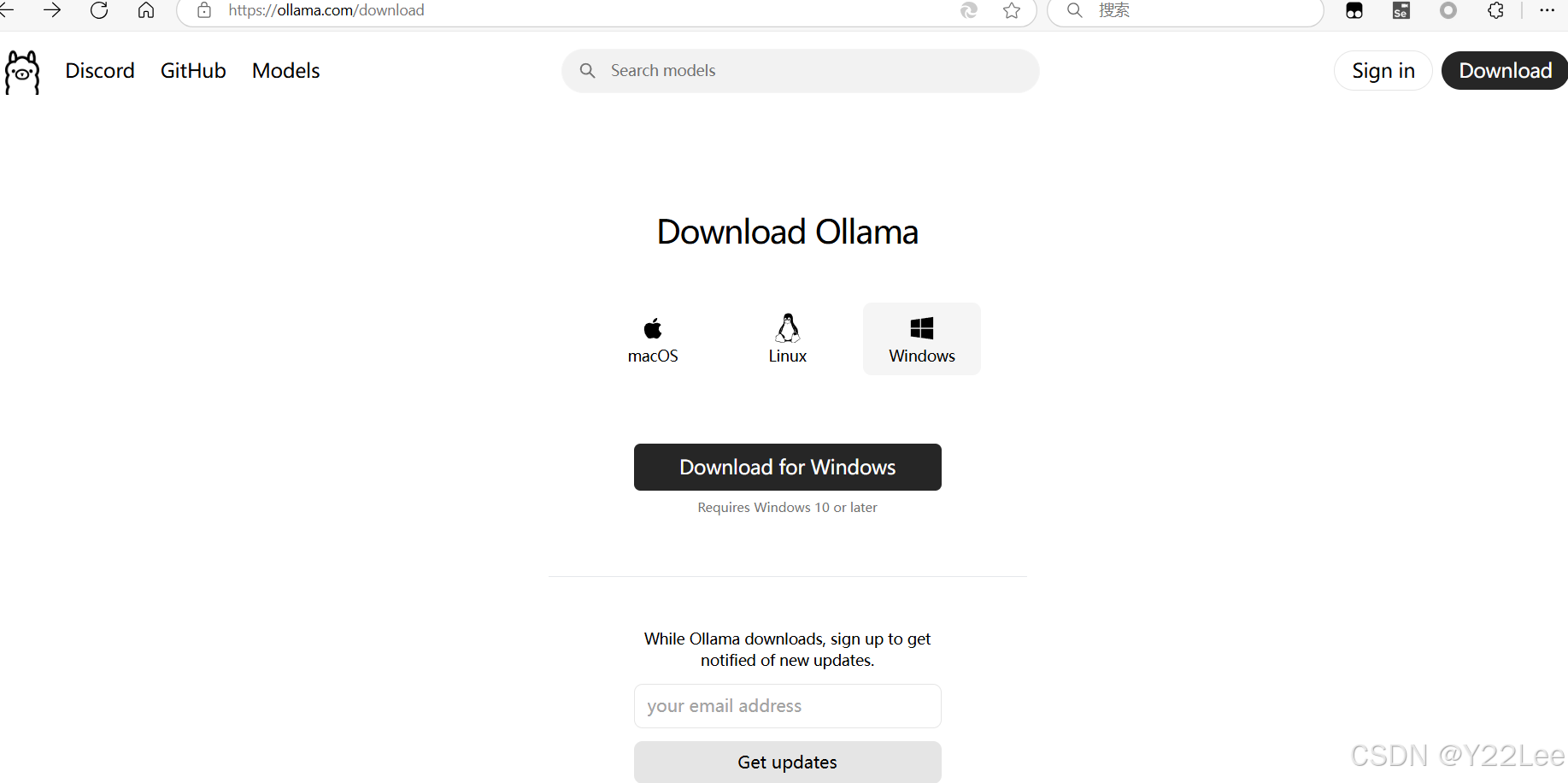

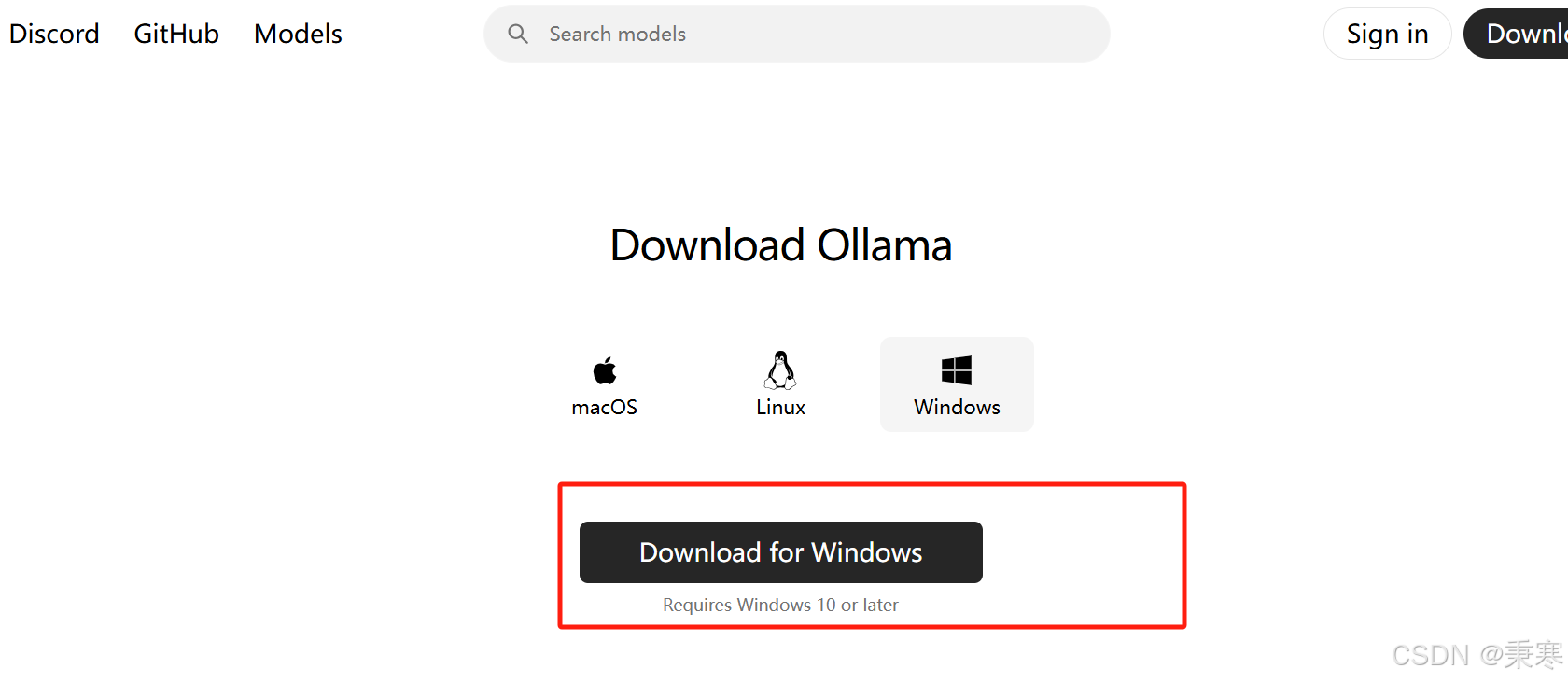

基础概念Ollama 是一个开源的人工智能平台,专注于大语言模型(Large Language Model, LLM)的本地部署和管理。它允许开发者在自己的服务器上运行多种预训练语言模型,如 GPT-3 或 ChatGPT,并通过 RESTful API 提供服务。Ollama 的核心优势在于其高效的本地推理能力,能够在资源有限的环境下快速响应用户查询。如下附上Ollama基础指令。

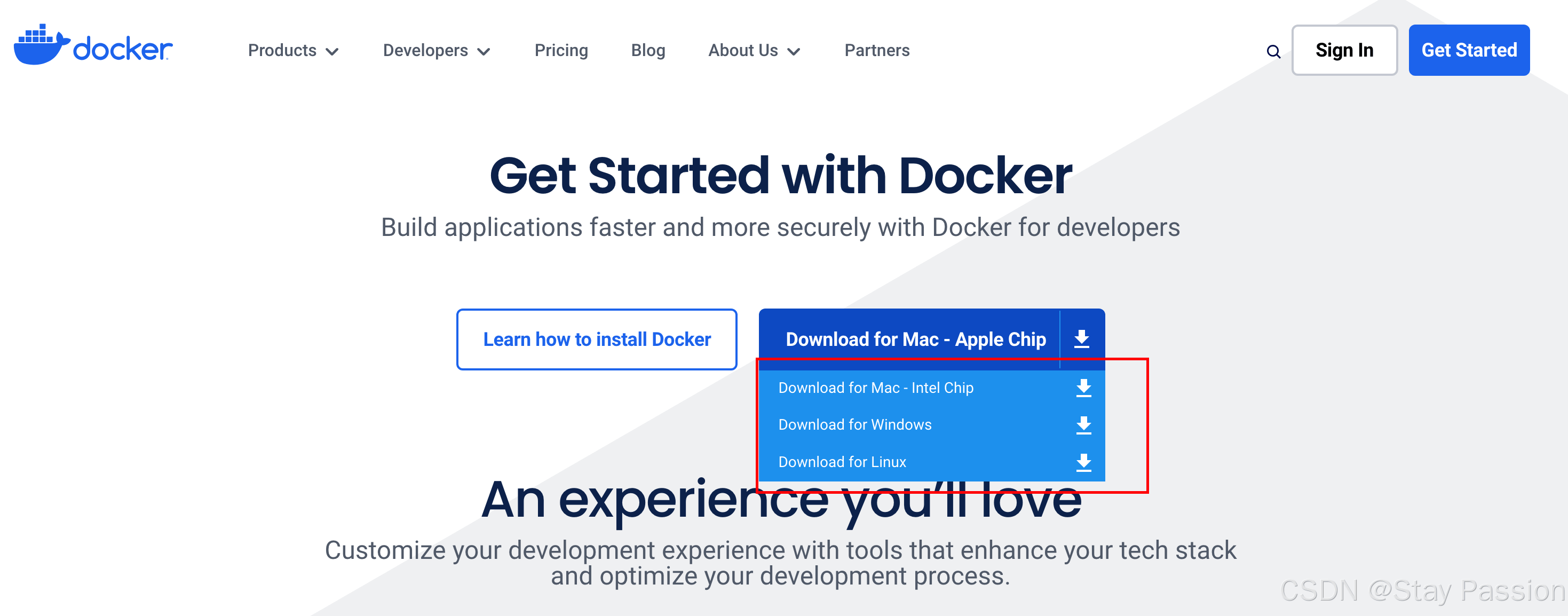

Docker是一种开源的容器化平台,用于将软件及其所有依赖环境打包到镜像文件中,以便于在任何环境下轻松运行。此处使用docker主要用于运行open-webui,以便于更方便的使用DeepSeek-R1。 搭建过程上述安装产品安装成功之后,便可以开始着手搭建DeepSeek-R1。

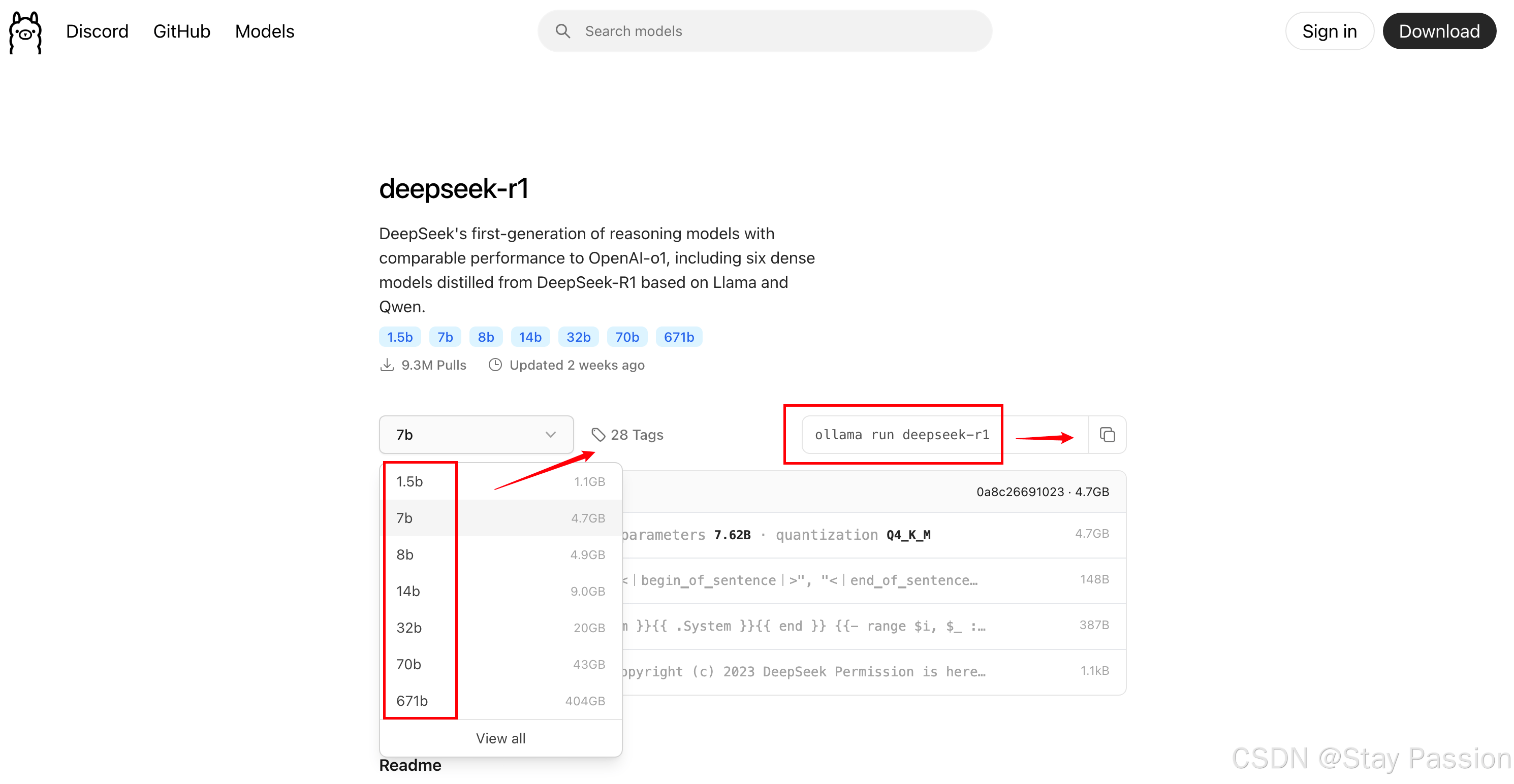

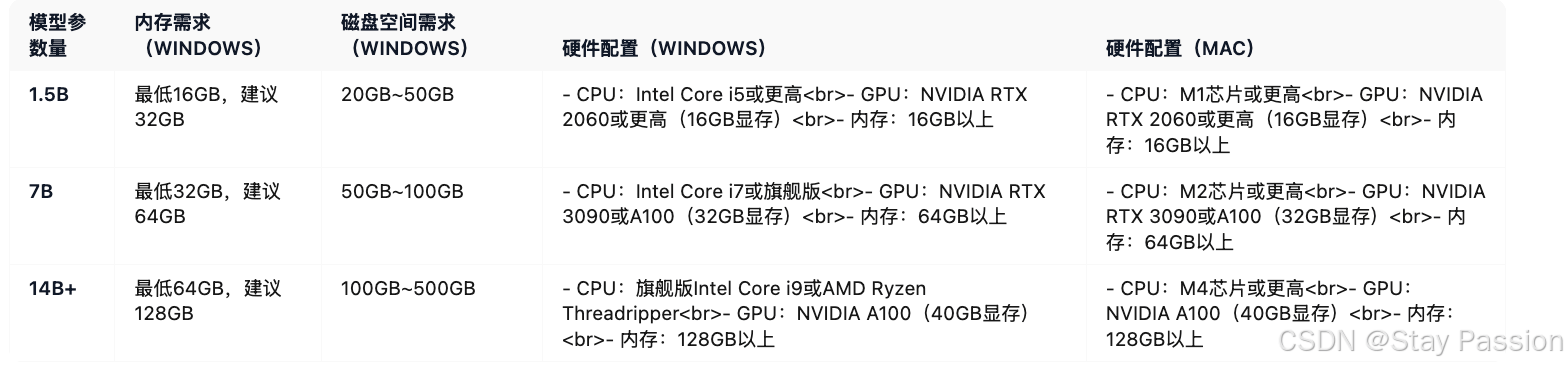

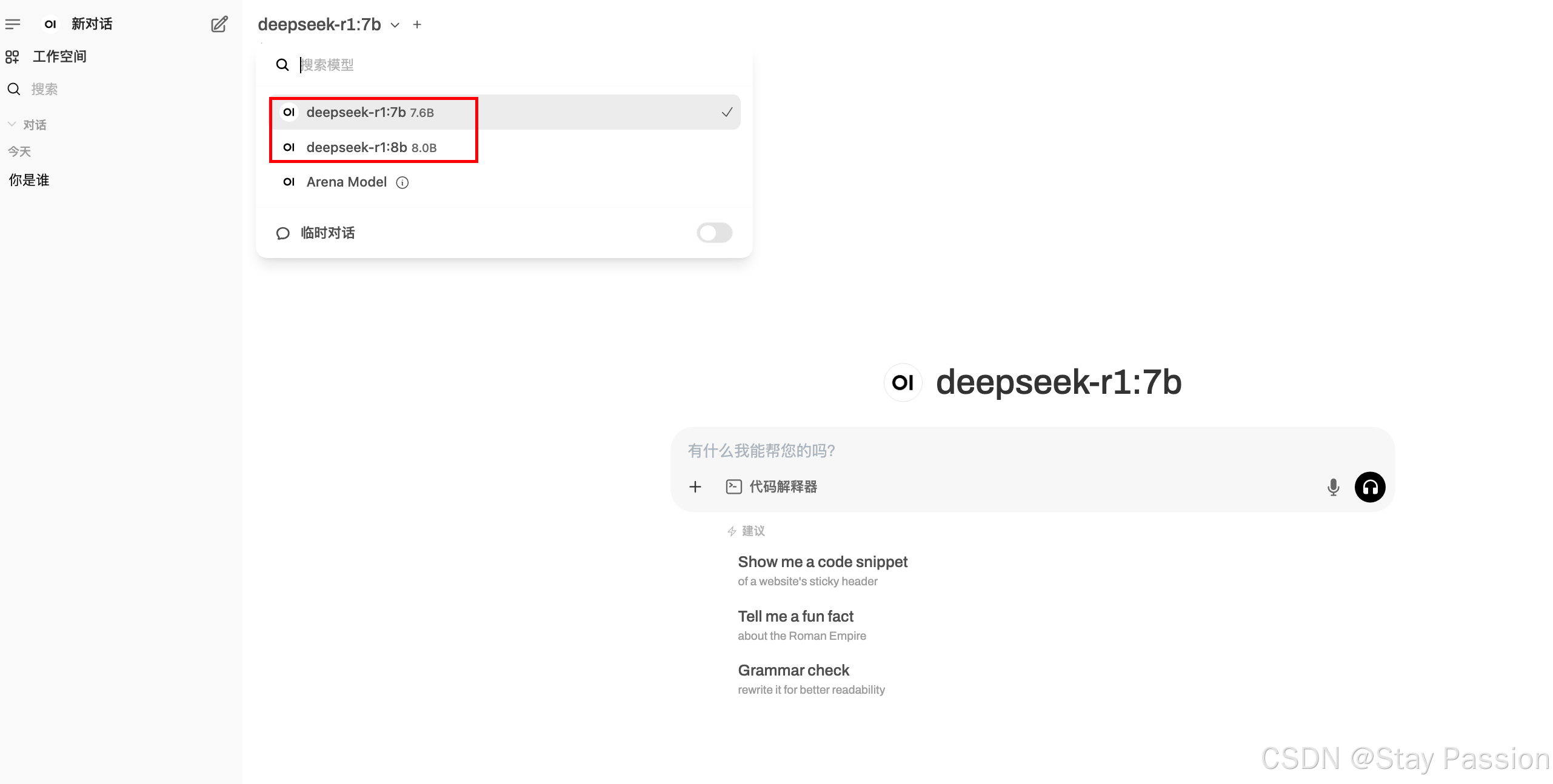

数字后面的b代表着算力参数,随着参数增加,训练和 inference 的计算量也显著增加,但也要选择和本地硬件相匹配。

配置对照表

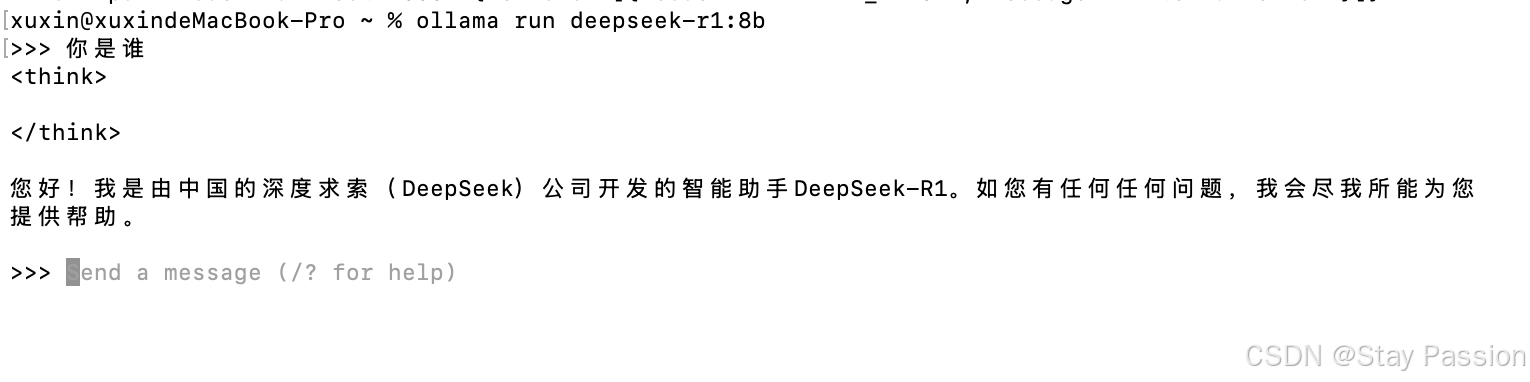

下载结束且成功之后(出现三个箭头),则可以进行问答。前期下载速度还是蛮快的,后面速度会越来越慢(FQ可有效提高下载速度),可以手动 control c 结束之后重新运行(会接着进行下载)。

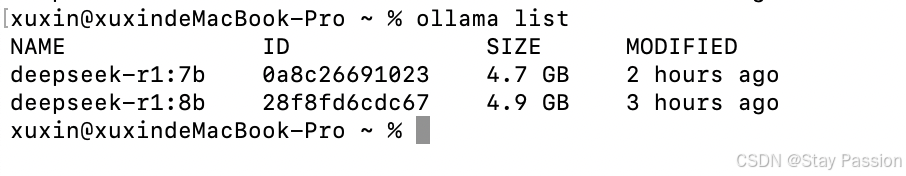

下载成功之后可以查询到下载的模型信息

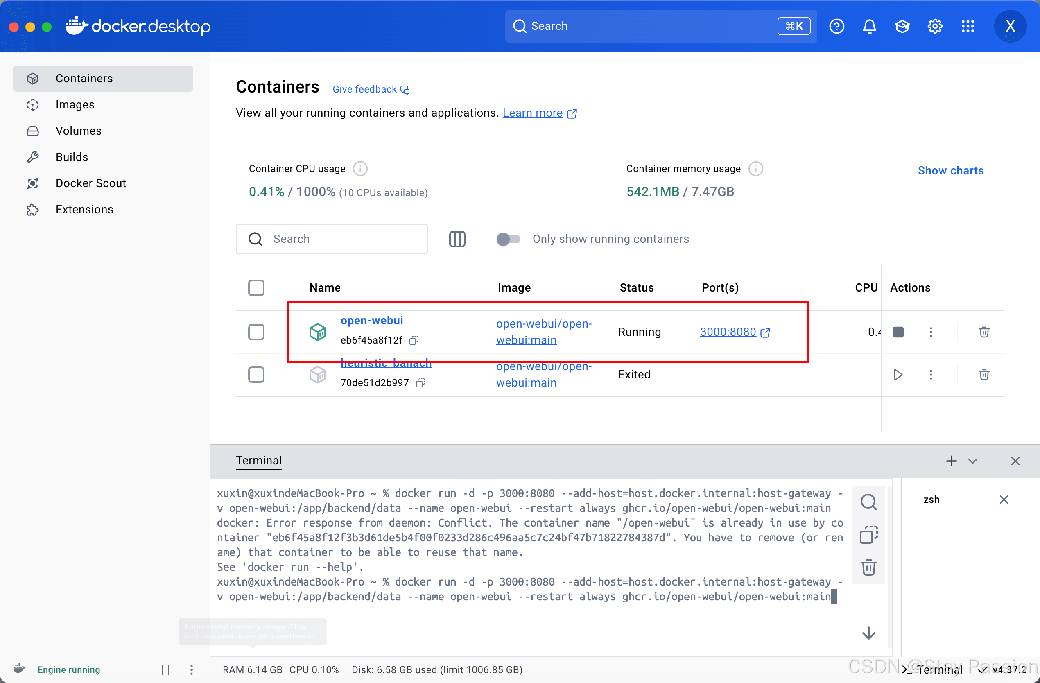

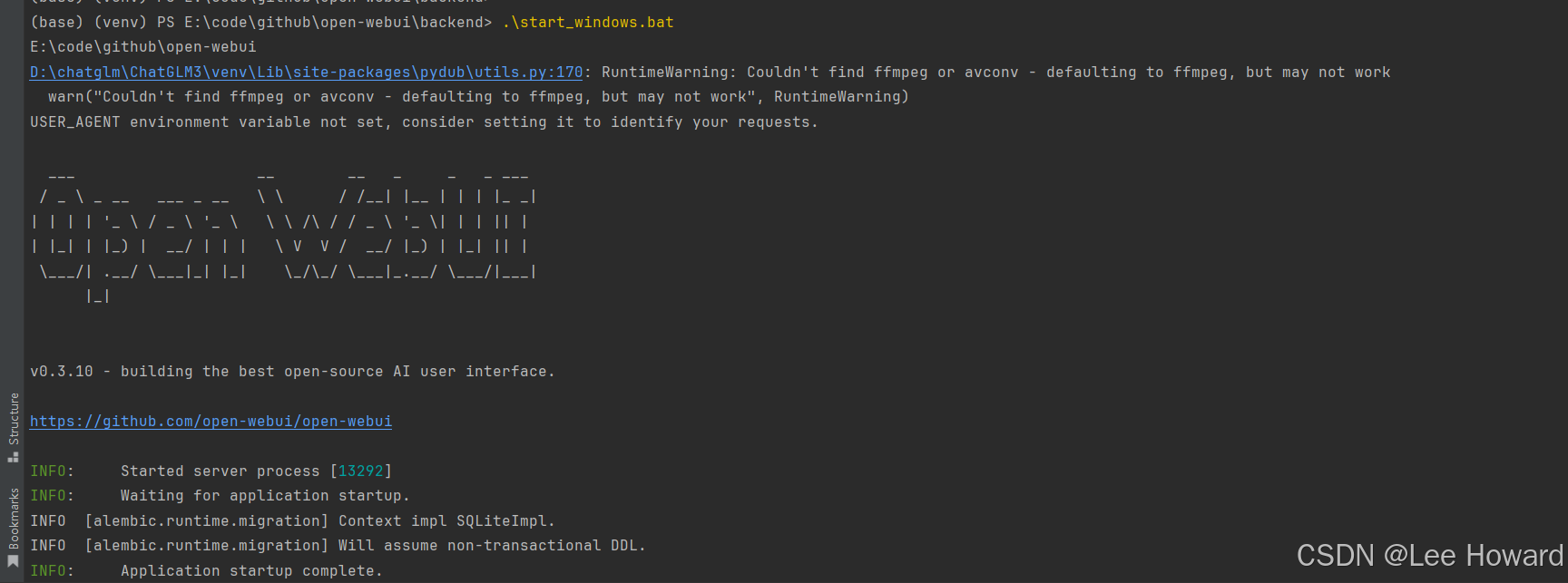

如上小黑框中的交互方式显然不能满足我们的要求,我们需要一个友好的交互页面(如ChatGpt一样),还可以记录下我们对话的内容。此时引入open web ui。 登录docker客户端并点击terminal输入如下命令:

步骤解释:

通过以上命令,您可以在本地启动一个WebUI服务,外部用户可以通过宿主机的3000端口访问。容器将自动重启,以应对崩溃或终止情况,并且数据会被持久保存以供后续使用。

访问WebUI本地访问地址: http://localhost:3000/ 登录成功之后可以选择我们下载好的对应模型进行对话。

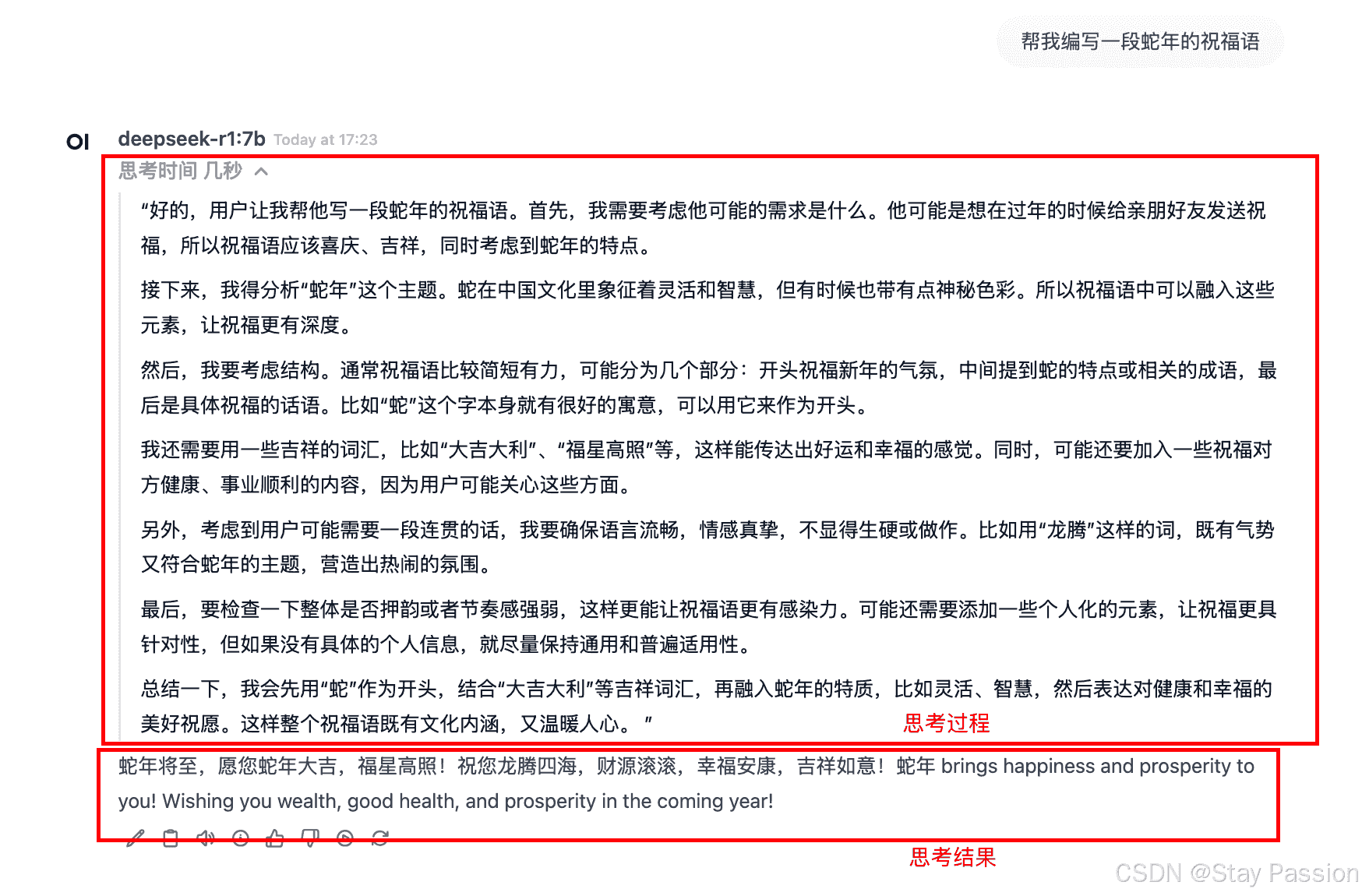

对话测试

综上,我们就完成了deepseek r1 的本地搭建。于用户角度,与ChatGpt相比,deepseek独有的思考过程让人眼前一亮。 |

您可能感兴趣的文章 :

-

DeepSeek本地部署流程介绍

随着人工智能技术的飞速发展,本地部署大模型的需求也日益增加。DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方 -

DeepSeek服务器繁忙问题的原因分析与解决方案(最

随着人工智能技术的飞速发展,DeepSeek 等语言模型在众多领域得到了广泛应用。然而,在春节这段时间的使用过程中,用户常常遭遇服务器 -

DeepSeek本地部署+可视化WebUI的实现(图文教程)

随着deepseek的大火,也萌生了想在本地搞一个AI帮助解决日常遇到的问题! 一.下载并安装Ollama 直接到官网点击下载即可ollam 下载好安装与其 -

DeepSeek本机部署详细步骤(基于Ollama和Docker管理)

在人工智能技术日新月异的时代,大语言模型的应用越来越广泛,DeepSeek 作为其中的佼佼者,备受开发者和技术爱好者的关注。通过在本机 -

利用DeepSeek实现复杂Git操作的介绍

今天综合利用DeepSeek V3和R1推理模型,成功解决了一个复杂的Git操作,谨以此文记录DeepSeek使用心得,以备后续复盘。这本是我一次操作上的 -

调用DeepSeek API的详细指南介绍

在本教程中,我将指导您如何获取 DeepSeek API 密钥,并演示如何使用该密钥进行 API 调试。 登录 DeepSeek 开放平台 首先,访问Deepseek 开放平台 -

Ollama整合open-webui的步骤及访问介绍

安装 官方安装地址:https://docs.openwebui.com/getting-started/ 有两种安装方式,docker和源码。 熟悉docker的同学可以采用该方式。 本文以源码的形式 -

本地搭建DeepSeek-R1、WebUI的完整过程及访问的详细

最近几年,人工智能技术的发展势头愈发强劲。无论是大型语言模型的突破,如美国OpenAI公司开发的ChatGPT,还是中国诸家企业在自主学习系 -

怎么在本地部署DeepSeek Janus Pro文生图大模型

Hello, 大家新年好。 在这个春节期间最火的显然是 DeepSeek 了。据不负责统计朋友圈每天给我推送关于 DeepSeek 的文章超过20篇。打开知乎跟B站 -

在本地快速部署deepseek的操作指南(3分钟极速部署

第一步,找到网站,下载: 首先找到Ollama, 根据自己的电脑下载对应的版本 。 我个人用的是Windows 我就先尝试用Windows版本了 ,文件不是很

-

解决Git Bash中文乱码的问题

2022-04-23

-

webp格式图片显示异常分析及解决方案

2023-04-23

-

typescript 实现RabbitMQ死信队列和延迟队

2024-04-08

-

git clone如何解决Permission Denied(publick

2024-11-15

-

Win10环境下编译和运行 x264的详细过程

2022-10-16