MAC快速本地部署Deepseek的实现介绍

相关技巧

来源:互联网

作者:佚名

发布时间:2025-02-24 20:05:00

人浏览

摘要

下载安装ollama 地址:https://ollama.com/Ollama 是一个开源的大型语言模型(LLM)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研究人员及爱好者能够高效地在本地环境中实验和集成

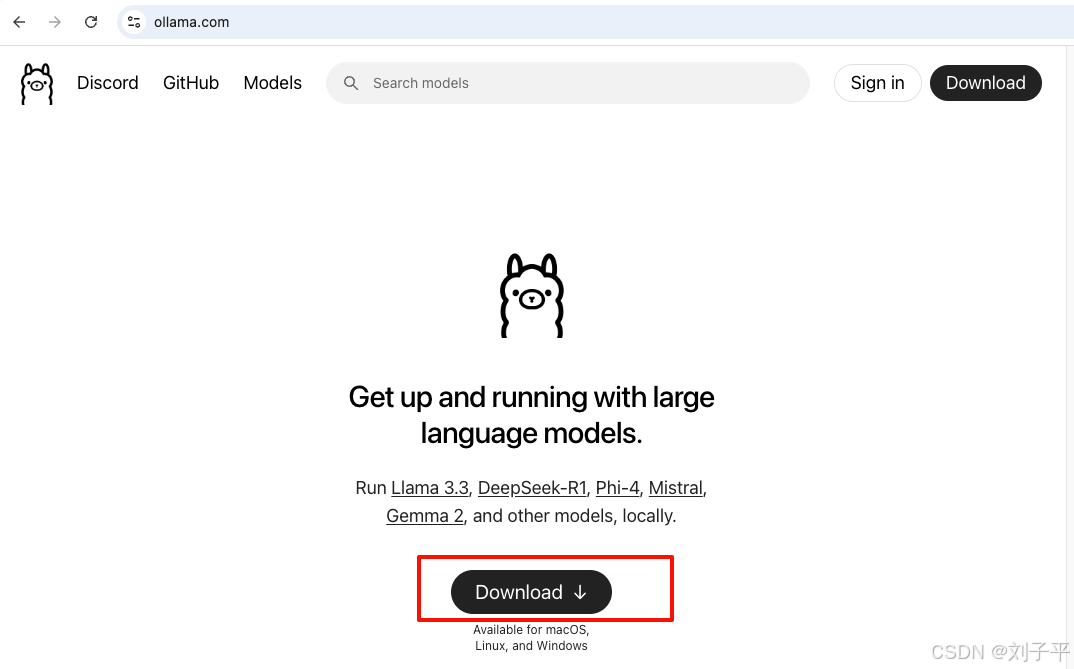

下载安装ollama地址: https://ollama.com/Ollama 是一个开源的大型语言模型(LLM)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研究人员及爱好者能够高效地在本地环境中实验和集成最新模型

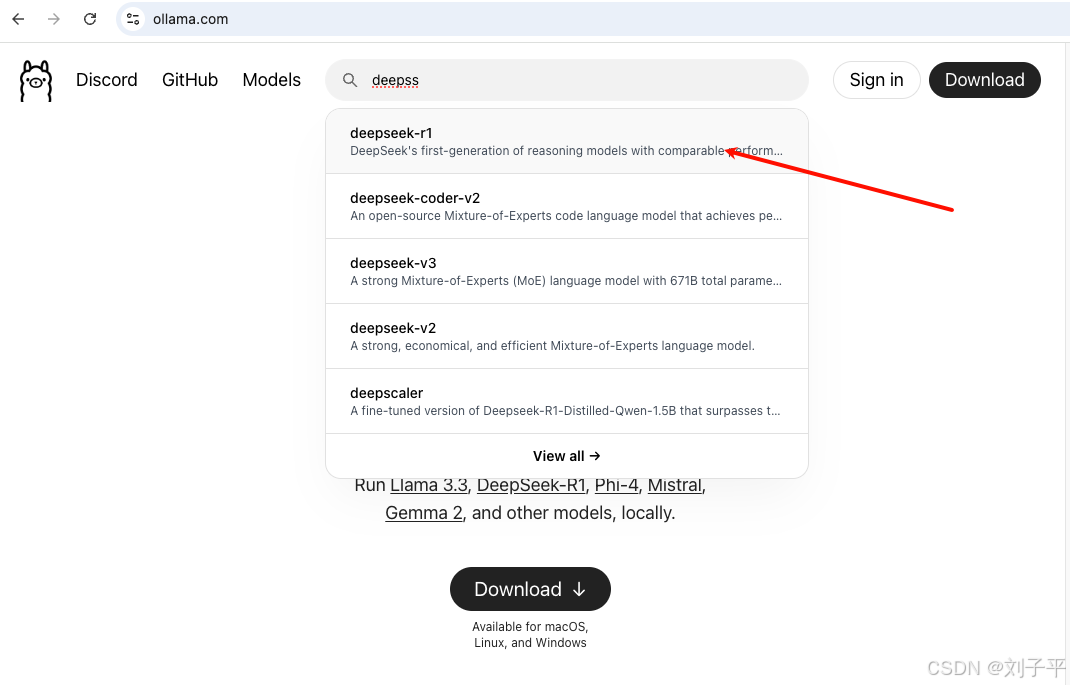

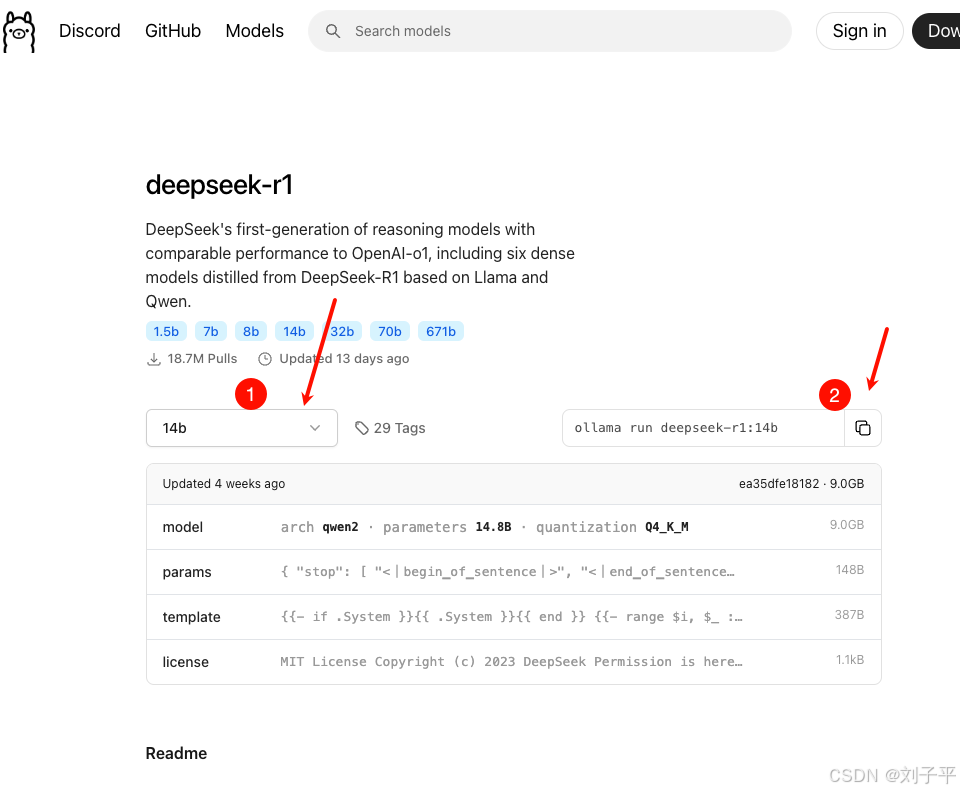

2. 根据自己需求, 选择合适的大模型版本 3. 本地电脑配置较差,我安装的14b

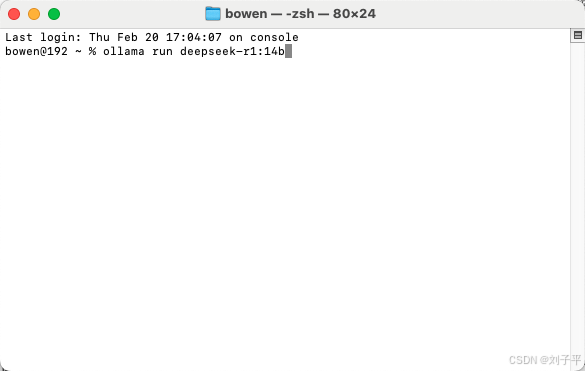

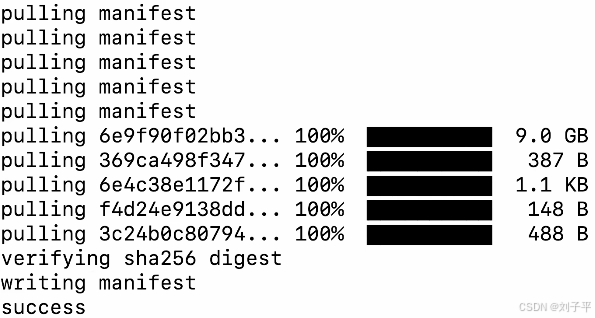

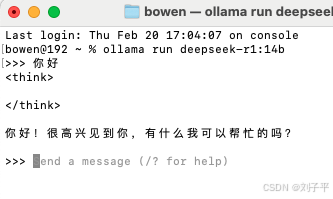

4. 复制命令 ollama run deepseek-r1:14b 到终端运行

看到 success就成功了 可以开始对话了 (首次较慢)

进阶不想用黑窗口的话 可以下载cherry Studio |

版权声明 : 本文内容来源于互联网或用户自行发布贡献,该文观点仅代表原作者本人。本站仅提供信息存储空间服务和不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权, 违法违规的内容, 请发送邮件至2530232025#qq.cn(#换@)举报,一经查实,本站将立刻删除。

您可能感兴趣的文章 :

- 高阶DeepSeek从入门到精通教程手册

- 基于DeepSeek-Coder的跨文件的代码

- 0基础租个硬件玩deepseek,蓝耘元生代智算云|本地部署DeepSeek R1模型的操作流程

- 在linux服务器本地部署Deepseek及在mac远程web-ui访问的操作

- 本地化部署DeepSeek 全攻略(linux、windows、mac系统部署)

- VScode内接入deepseek包过程记录

- deepseek本地部署流程(解决服务器繁忙以及隐私等问题)

- 完美解决DeepSeek服务器繁忙问题

- Deepseek R1模型本地化部署+API接口调用详细教程(释放AI生产力)

- DeepSeek部署之GPU监控指标接入Prometheus的过程

原文链接 :

相关文章

-

高阶DeepSeek从入门到精通教程手册

第?章:准备篇(三分钟上手) 1.1 三分钟创建你的 AI 伙伴 1、访问官网:浏览器输?www.deepseek.com; 2、注册账号:点击开始对话,进入新用户 -

后端编程语言多方面对比:JAVA、C、C++、GO、PYT

软件开发领域,语言本身在各自领域都有适用场景,有许多流行的编程语言可供选择,每种语言都有其独特的特点和适用场景。 Java、C、C -

MAC快速本地部署Deepseek的实现介绍

下载安装ollama 地址:https://ollama.com/Ollama 是一个开源的大型语言模型(LLM)本地运行框架,旨在简化大模型的部署和管理流程,使开发者、研 -

GBK与UTF-8互转乱码问题介绍

GBK与UTF-8互转乱码问题 我们知道在计算机内存中,存储的是二进制数据,在网络传输中,也是二进制数据,但最终呈现给用户的是字符串, -

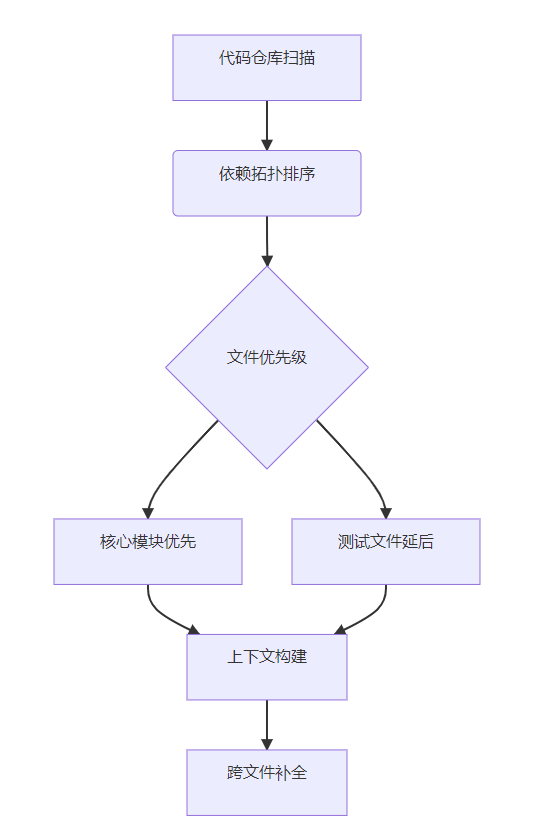

基于DeepSeek-Coder的跨文件的代码

一、环境准备与基础配置 1.1 安装DeepSeek-Coder SDK 1 2 3 4 5 安装最新版SDK(需Python 3.10+) pip install deepseek-coder --upgrade 环境验证(获取API密钥后 -

0基础租个硬件玩deepseek,蓝耘元生代智算云|本地部

0基础租个硬件玩deepseek,蓝耘元生代智算云|本地部署DeepSeek R1模型,3步搞定一个应用 最近DeepSeek-R1 系列推理能力比肩 OpenAI o1;想弄个玩玩。 -

使用Ollama服务监听0.0.0.0地址

一、为什么需要监听0.0.0.0地址? 在计算机网络中,0.0.0.0是一个特殊的IP地址,它表示本机上的所有IPv4地址。 当我们将一个服务配置为监听 -

在linux服务器本地部署Deepseek及在mac远程web-ui访问

1. 在Linux服务器上部署DeepSeek模型 要在 Linux 上通过 Ollama 安装和使用模型,您可以按照以下步骤进行操作: 步骤 1:安装 Ollama 安装 Ollama: -

本地化部署DeepSeek 全攻略(linux、windows、mac系统部

一、Linux 系统部署 准备工作 硬件要求:服务器需具备充足计算资源。推荐使用 NVIDIA GPU,如 A100、V100 等,能加快模型推理速度。内存至少 -

Win10环境借助DockerDesktop部署大数据时序数据库A

Win10环境借助DockerDesktop部署最新版大数据时序数据库Apache Druid32.0.0 前言 大数据分析中,有一种常见的场景,那就是时序数据,简言之,数据

推荐阅读

-

解决Git Bash中文乱码的问题

2022-04-23

-

webp格式图片显示异常分析及解决方案

2023-04-23

-

typescript 实现RabbitMQ死信队列和延迟队

2024-04-08

-

git clone如何解决Permission Denied(publick

2024-11-15

-

Win10环境下编译和运行 x264的详细过程

2022-10-16

最新更新