YOLOv8模型pytorch格式转为onnx格式的步骤介绍

一、YOLOv8的Pytorch网络结构 yolov8网络从1-21层与pt文件相对应是BackBone和Neck模块,22层是Head模块。 二、转ONNX步骤 2.1 yolov8官方 1 2 3 4 5 6 7 8 9 10 代码解释 pt模型转为onnx格式 import os from ultralytics i

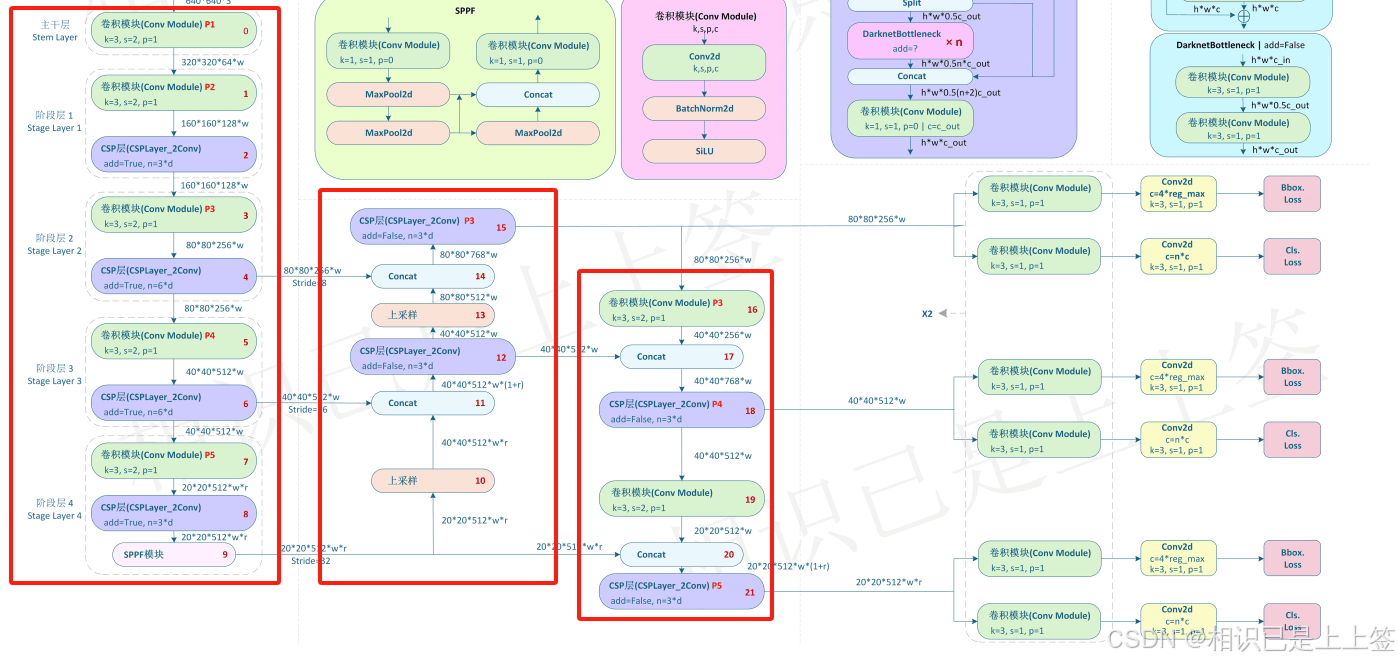

一、YOLOv8的Pytorch网络结构

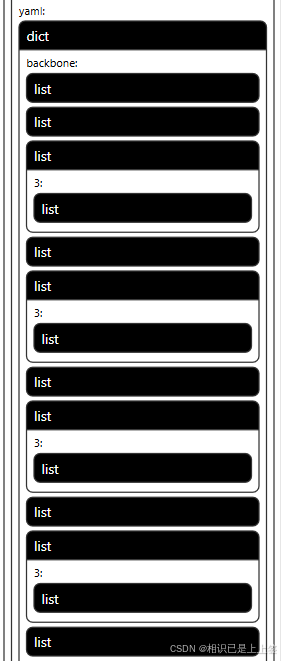

yolov8网络从1-21层与pt文件相对应是BackBone和Neck模块,22层是Head模块。

二、转ONNX步骤2.1 yolov8官方

将pytorch转为onnx后,pytorch支持的一系列计算就会转为onnx所支持的算子,若没有相对应的就会使用其他方式进行替换(比如多个计算替换其单个)。比较常见是conv和SiLU合并成一个Conv模块进行。

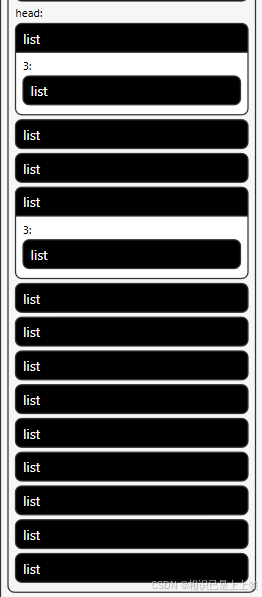

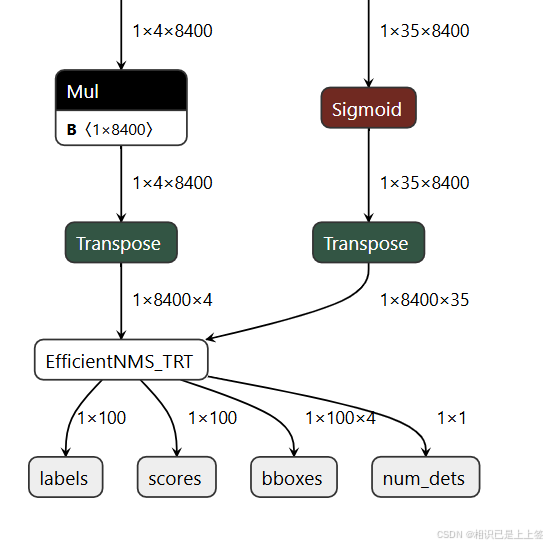

其中,1*4*8400表示每张图片预测 8400 个候选框,每个框有 4 个参数边界框坐标 (x,y,w,h)。 1*35*8400类同,1和4800代表意义相同,35是类别属性包含了其置信度概率值。 最后两个输出Concat操作,得到1*39*8400。最后根据这个结果去进行后续操作。 2.2 自定义转换所谓的自定义转换其实是在转onnx时,对1*39*8400多加了一系列自定义操作例如NMS等。 2.2.1 加载权重并优化结构

2.2.2 后处理检测模块

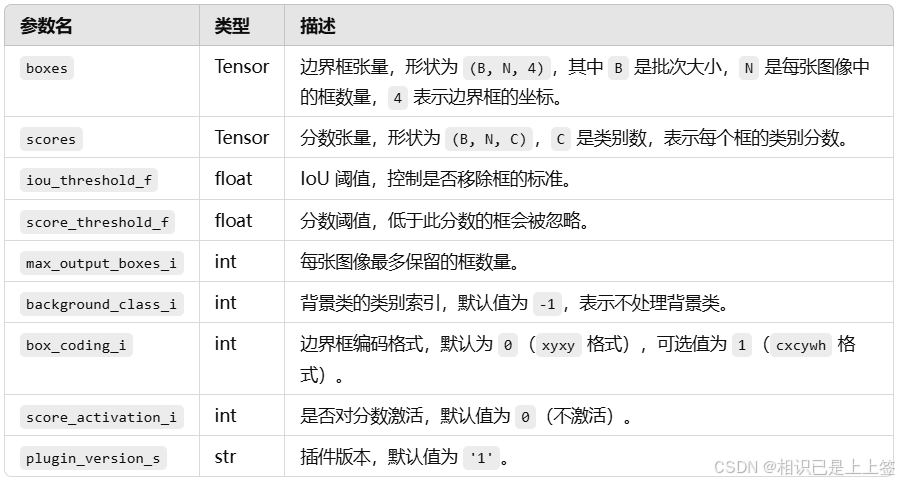

自定义这里是在yolo官方得到的1*4*8400和1*35*8400进行矩阵转换2<->3,最后引入EfficientNMS_TRT插件后处理,可以有效加速NMS处理。 2.2.3 EfficientNMS_TRT插件EfficientNMS_TRT 是 TensorRT 中的一个高效非极大值抑制 (NMS) 插件,用于快速过滤检测框。它通过优化的 CUDA 实现来执行 NMS 操作,特别适合于深度学习推理阶段中目标检测任务的后处理。支持在一个批次中对多个图像同时执行 NMS。

输出结果为num_dets, detection_boxes, detection_scores, detection_classes ,分别代表经过 NMS 筛选后保留的边界框数,每张图片保留的检测框的坐标,每张图片中保留下来的检测框的分数(由高到低),每个保留下来的边界框的类别索引。 |

您可能感兴趣的文章 :

-

基于Python制作一个全自动微信清粉小工具

在当今社交软件中,微信是最常用的通讯工具之一。然而,随着时间的推移,我们的好友列表中可能会出现一些不再活跃的账号,也就是我 -

YOLOv8模型pytorch格式转为onnx格式的步骤介绍

一、YOLOv8的Pytorch网络结构 yolov8网络从1-21层与pt文件相对应是BackBone和Neck模块,22层是Head模块。 二、转ONNX步骤 2.1 yolov8官方 1 2 3 4 5 6 7 8 9 -

Python中addict库使用Dict的类

from addict import Dict这行代码导入了 Dict 类,它来自于 addict 模块。在这个上下文中,addict 是一个 Python 库,它提供了一个名为 Dict 的类,用于 -

Python利用标签实现清理微信好友的自动化脚本

微信已经成为我们日常生活中不可或缺的社交工具。随着使用时间的增长,我们的微信好友列表可能会变得越来越臃肿。 在上一篇文章中, -

Python判断空的五种方法介绍

一、使用if语句判断 在Python中,可以使用if语句判断一个变量是否为空,若为空,则可以执行相应的操作。 此处判断的是var是否为None,如果 -

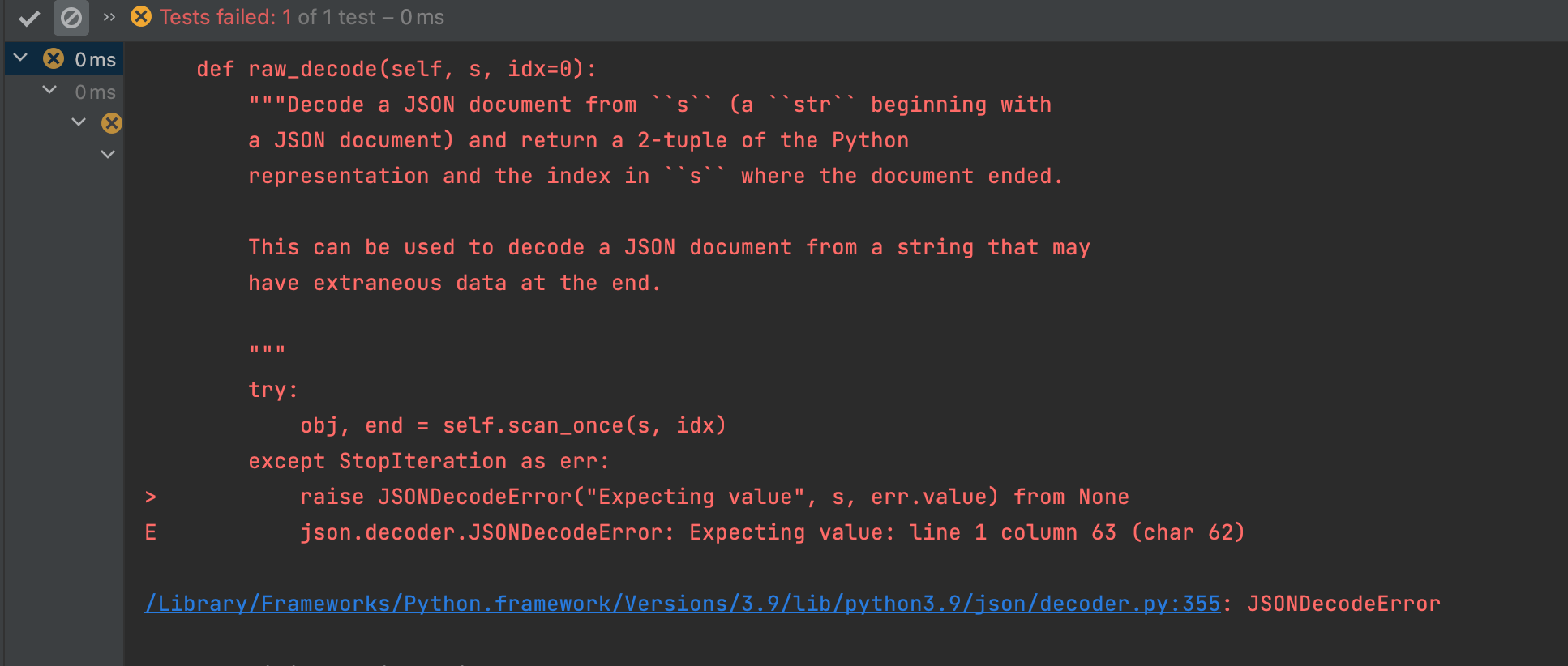

Python的json模块中json.load()和json.loads()的区别

json.load和json.loads都是Python的json模块中用于解析JSON数据的方法,但它们之间有一些重要的区别。 1. json.load json.load用于从一个文件对象中读取 -

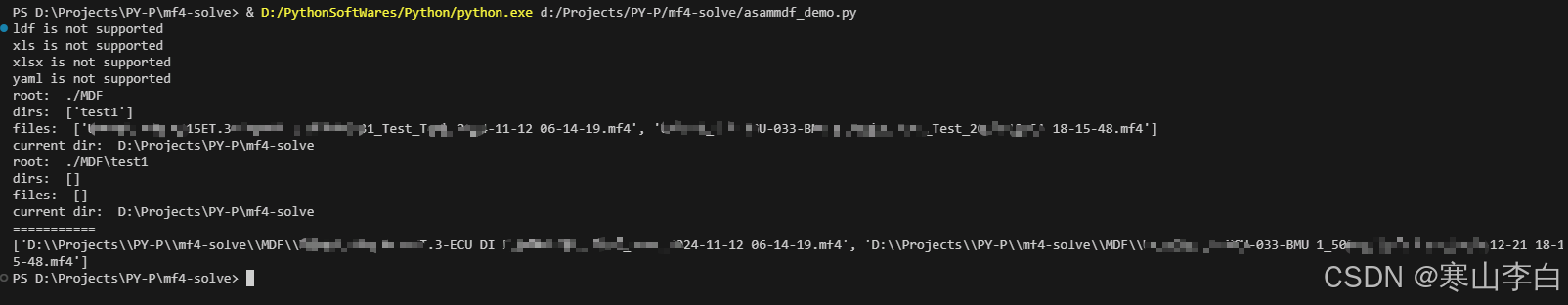

Python遍历文件和文件路径拼接介绍

一、os.walk()文件(夹)读取 遍历指定路径下的所有文件和文件夹 示例代码如下 1 2 3 4 5 6 7 8 9 10 mdfFolder= D:\hanshan\MDF for root, dirs, files in os.w -

Python如何使用组合方式构建复杂正则

正则写复杂了很麻烦,难写难调试,只需要两个函数,就能用简单正则组合构建复杂正则: 比如输入一个字符串规则,可以使用{name}引用前 -

4个必学的Python自动化技巧

在当今快节奏的工作环境中,自动化是提升效率的重要手段。Python作为一种强大且易用的编程语言,在自动化领域有着广泛的应用。本文将 -

Python获取Windows桌面路径的三种方法

1 概述 因为某些原因,需要使用不同用户的 Windows 桌面路径,故无法对路径进行固定,可使用下列方法进行获取 2 方法 2.1 方法1:使用 os 模

-

python批量下载抖音视频

2019-06-18

-

利用Pyecharts可视化微信好友的方法

2019-07-04

-

python爬取豆瓣电影TOP250数据

2021-05-23

-

基于tensorflow权重文件的解读

2021-05-27

-

解决Python字典查找报Keyerror的问题

2021-05-27