利用Python定位Span标签中文字

在开始之前,需要确保安装了必要的Python库。requests库用于发送HTTP请求,获取网页内容;BeautifulSoup库用于解析HTML文档,提取所需信息。 可以使用以下命令安装这些库: pip install requests beauti

|

在开始之前,需要确保安装了必要的Python库。requests库用于发送HTTP请求,获取网页内容;BeautifulSoup库用于解析HTML文档,提取所需信息。 可以使用以下命令安装这些库: pip install requests beautifulsoup4 lxml 二、基本流程

三、代码示例以下是一个简单的示例,演示了如何定位并提取<span>标签中的文字。

四、案例分析假设我们要抓取一个包含以下HTML结构的网页中的<span>内容:

我们的目标是提取<span class="title">中的文本内容,即"Hello, World!"。 发送HTTP请求:

解析HTML并定位<span>标签:

完整代码:

五、进阶技巧处理多个<span>标签:如果网页中有多个<span>标签,可以使用find_all方法获取所有匹配的标签,并遍历它们。

根据其他属性定位:除了类名,还可以根据<span>标签的其他属性(如id、name等)进行定位。

结合XPath:对于更复杂的HTML结构,可以使用lxml库提供的XPath功能进行定位。不过,这通常需要更多的HTML和XPath知识。

使用Selenium:对于需要模拟用户操作(如点击、输入等)的场景,可以使用Selenium库。Selenium支持多种浏览器,并且可以通过XPath、CSS选择器等方式定位元素。

六、注意事项

七、总结通过本文的介绍,读者应该已经掌握了如何使用Python定位并提取<span>标签中的文字。无论是使用requests和BeautifulSoup进行简单的HTML解析,还是使用Selenium进行复杂的网页操作,都可以轻松实现这一目标。希望本文能够帮助读者在实际项目中更好地应用这些技术。 |

您可能感兴趣的文章 :

-

Python实现Ollama的提示词生成与优化

1. 基础环境配置 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 import requests import json from typing import List, Dict, Optional from dataclasses import dataclass @dataclas -

利用Python定位Span标签中文字

在开始之前,需要确保安装了必要的Python库。requests库用于发送HTTP请求,获取网页内容;BeautifulSoup库用于解析HTML文档,提取所需信息。 可 -

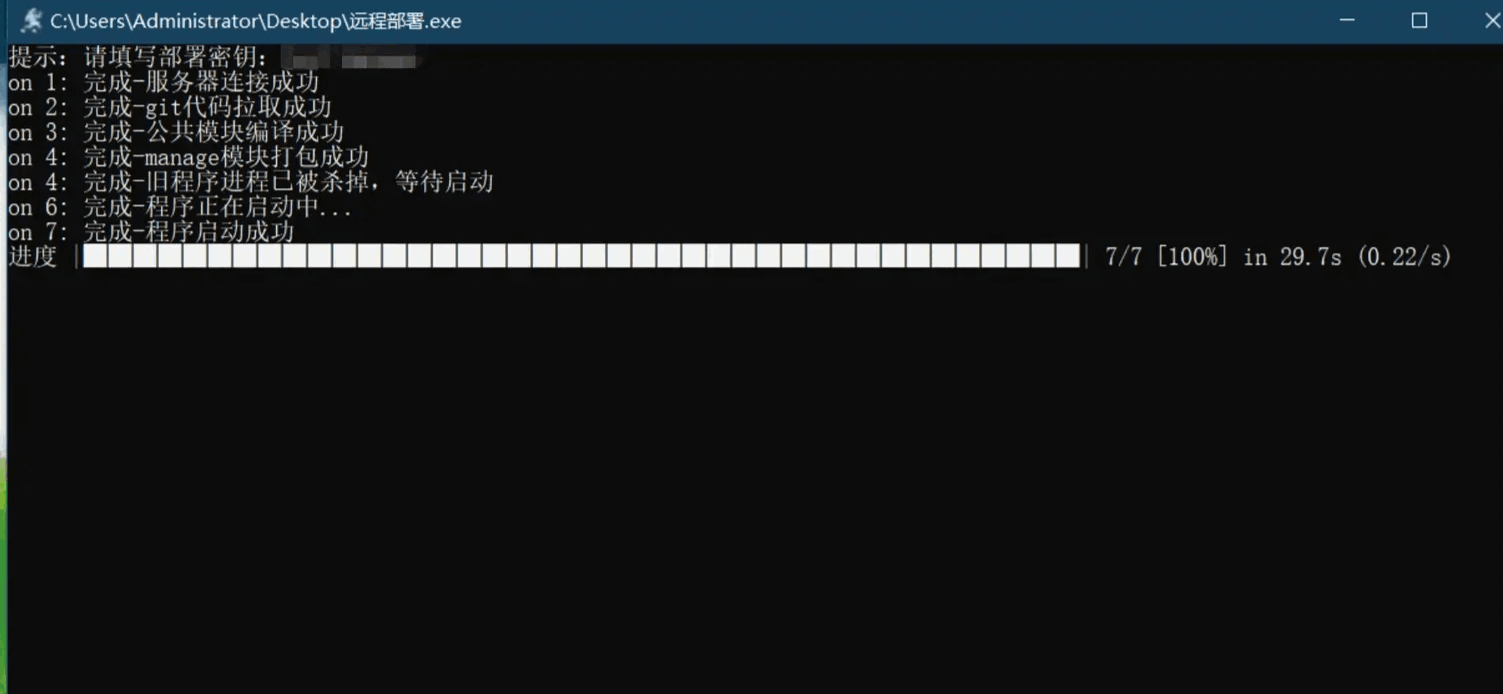

使用python编写一个自动化部署工具

效果 起因 现在springboot项目的自动化部署已经非常普遍,有用Jenkins的,有用git钩子函数的,有用docker的...等等。这段时间在玩python,想着用 -

Python中的下划线“_”们介绍

随便拿一份Python代码,几乎都可以看到很多_的身影。 在Python中,下划线(_)有多种用途和含义,具体取决于它们的位置和使用方式。在这 -

OpenCV-Python给图像去除水印多种方法

去除水印的过程与添加水印相反,它涉及到图像修复、颜色匹配和区域填充等技术。OpenCV-Python 提供了多种方法来处理不同类型的水印,包括 -

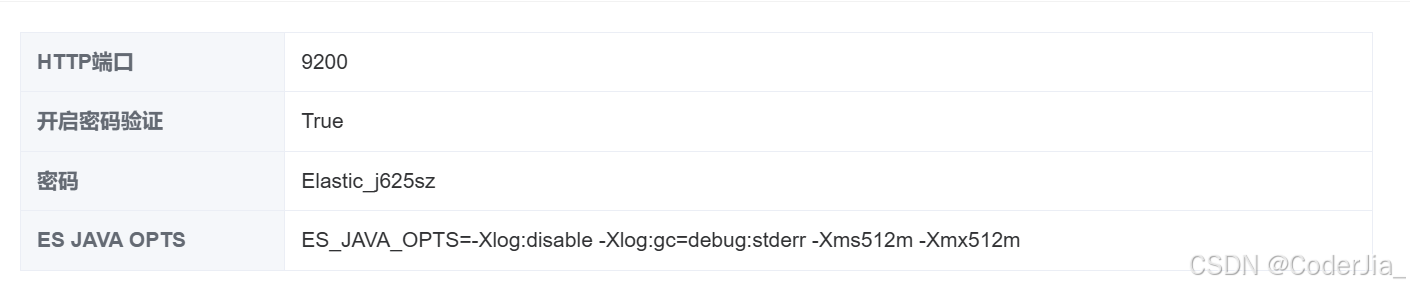

Python连接和操作Elasticsearch

一、服务器端配置 在开始之前,确保你的 Elasticsearch 服务已经在服务器上正确安装和配置。 以下是一些基本的配置步骤: 1. 修改 Elasticse -

python随机种子ranrandom seed的使用介绍

在Python中启用随机种子(random seed)是为了确保你的随机数生成过程是可重复的。通过设置随机种子,你可以保证每次运行代码时生成的随机 -

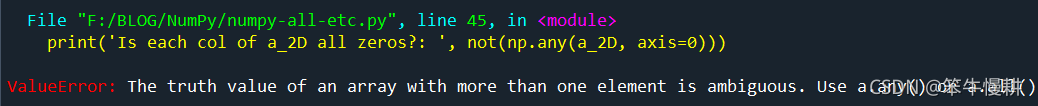

Numpy判断数组是否全0的三种方法

1numpy.any() numpy.any()函数用于检查一个numpy数字是否存在任何一个非0元素,因此将numpy.any()的结果取反即得numpy数组是否全0的结果。例如: 1 -

python实现字符串逆序输出的几种方法

方法一:使用切片(Slicing) 1 2 3 4 5 6 def reverse_string(s): return s[::-1] s=str(input(请输入字符串:)) reversed_string=reverse_string(s) print(reversed_string) 在

-

python批量下载抖音视频

2019-06-18

-

利用Pyecharts可视化微信好友的方法

2019-07-04

-

python爬取豆瓣电影TOP250数据

2021-05-23

-

基于tensorflow权重文件的解读

2021-05-27

-

解决Python字典查找报Keyerror的问题

2021-05-27