Python实现敏感词过滤的五种方法

1、replace替换 replace就是最简单的字符串替换,当一串字符串中有可能会出现的敏感词时,我们直接使用相应的replace方法用*替换出敏感词即可。 缺点: 文本和敏感词少的时候还可以,多的时候

1、replace替换replace就是最简单的字符串替换,当一串字符串中有可能会出现的敏感词时,我们直接使用相应的replace方法用*替换出敏感词即可。 缺点: 文本和敏感词少的时候还可以,多的时候效率就比较差了。 示例代码:

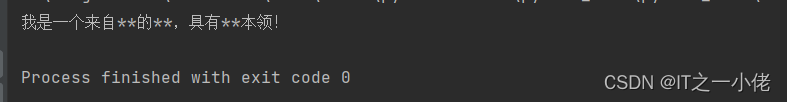

运行结果:

如果是多个敏感词可以用列表进行逐一替换。 示例代码:

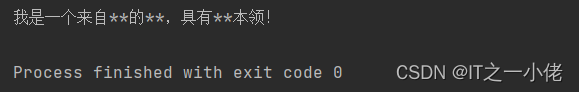

运行效果:

2、正则表达式使用正则表达式是一种简单而有效的方法,可以快速地匹配敏感词并进行过滤。在这里我们主要是使用“|”来进行匹配,“|”的意思是从多个目标字符串中选择一个进行匹配。 示例代码:

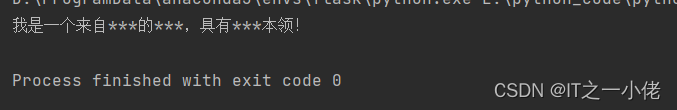

运行结果:

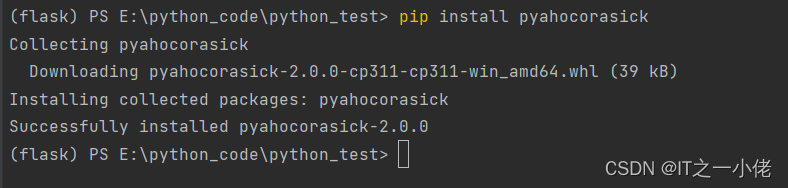

3、使用ahocorasick第三方库ahocorasick库安装:

示例代码:

运行结果:

4、字典树使用字典树是一种高效的方法,可以快速地匹配敏感词并进行过滤。 示例代码:

运行结果:

5、DFA算法使用DFA算法是一种高效的方法,可以快速地匹配敏感词并进行过滤。DFA的算法,即Deterministic Finite Automaton算法,翻译成中文就是确定有穷自动机算法。它的基本思想是基于状态转移来检索敏感词,只需要扫描一次待检测文本,就能对所有敏感词进行检测。 示例代码:

运行结果:

|

您可能感兴趣的文章 :

-

Python Socket网络编程的7种硬核用法

上周老板拍着我的肩膀说:小花啊,我们需要一个在线客服系统,你用 Python 搞个 Socket 聊天室吧! 我心里嘀咕:Socket 不就发发消息、写个 -

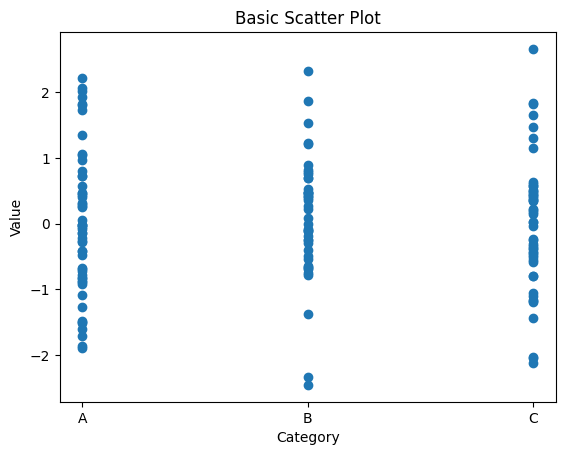

Python使用Matplotlib绘制Swarm Plot(蜂群图)的代码

Swarm Plot(蜂群图)是一种数据可视化图表,它用于展示分类数据的分布情况。这种图表通过将数据点沿着一个或多个分类变量轻微地分散, -

Python中的异步与同步深度解析

Python中的异步与同步:深度解析与实践 在Python编程世界里,异步和同步的概念是理解程序执行流程和性能优化的关键。这篇文章将带你深入 -

Python异步编程中asyncio.gather的并发控制的介绍

在Python异步编程生态中,asyncio.gather是并发任务调度的核心工具。然而当面对海量任务时,不加控制的并发可能引发资源耗尽、服务降级等问 -

python中time模块的常用方法及应用

一、时间基石:time.time() time.time()是获取时间戳的入口函数,返回自1970年1月1日(Unix纪 元)以来的秒数(浮点数)。这个10位数字像时间维 -

讯飞webapi语音识别接口调用代码(python)

基于python3 讯飞webAPI语音识别 接口调用的实现。 一、环境 1、注册讯飞平台账号:讯飞平台网址 2、进入控制台并创建应用 3、进入应用后点 -

Python不支持中文路径的解决方法

在编程的世界里,遇到问题并不罕见,但有些问题可能会让人感到格外棘手。比如,你是否曾经在使用Python处理文件时,因为路径中包含中 -

Python使用DeepSeek进行联网搜索功能

在当今信息爆炸的时代,联网搜索已成为获取数据、优化模型效果的重要手段。Python作为一种非常流行的编程语言,结合DeepSeek这一高性能的

-

python批量下载抖音视频

2019-06-18

-

利用Pyecharts可视化微信好友的方法

2019-07-04

-

python爬取豆瓣电影TOP250数据

2021-05-23

-

基于tensorflow权重文件的解读

2021-05-27

-

解决Python字典查找报Keyerror的问题

2021-05-27