最近在学爬虫时发现许多网站都有自己的反爬虫机制,这让我们没法直接对想要的数据进行爬取,于是了解这种反爬虫机制就会帮助我们找到解决方法。 常见的反爬虫机制有判别身份和IP限制两种,下面我们将一一来进行介绍。 (一) 判别身份 首先我们看一个例子,看

|

最近在学爬虫时发现许多网站都有自己的反爬虫机制,这让我们没法直接对想要的数据进行爬取,于是了解这种反爬虫机制就会帮助我们找到解决方法。

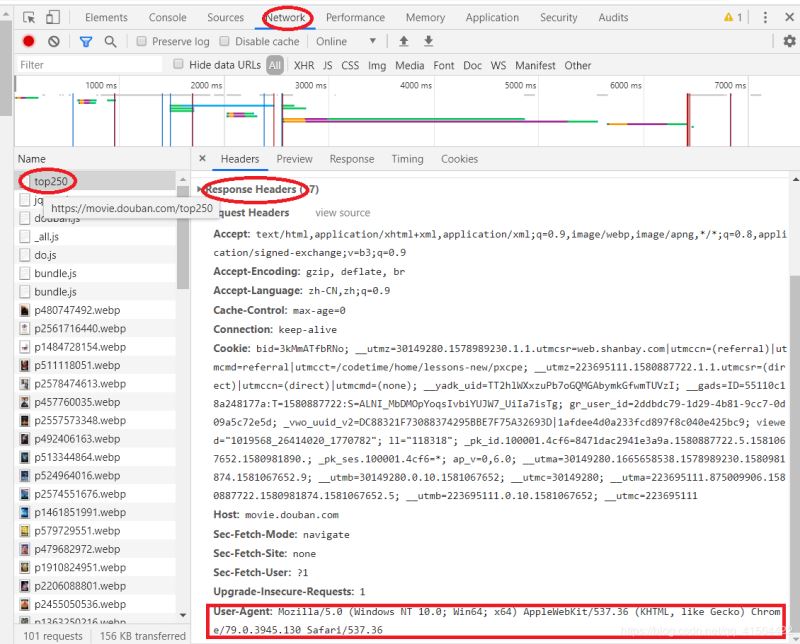

这是段简单的请求与网站连接并打印获取数据的代码,我们来看看它的运行结果。  我们可以发现我们什么数据都没有获取到,这就是由于这个网站有它的身份识别功能,把我们识别为了爬虫,拒绝为我们提供数据。不管是浏览器还是爬虫访问网站时都会带上一些信息用于身份识别。而这些信息都被存储在一个叫请求头(request headers) 的地方。而这个请求头中我们只需要了解其中的一个叫user-agent(用户代理) 的就可以了。user-agent里包含了操作系统、浏览器类型、版本等信息,通过修改它我们就能成功地伪装成浏览器。 下面我们来看怎么找这个user-agent吧。 首先得打开浏览器,随便打开一个网站,再打开开发者工具。 再点击network标签,接着点第一个请求,再找到Request Headers,最后找到user-agent字段。(有时候可能点击network标签后是空白得,这时候刷新下网页就好啦!)  找到请求头后,我们只需要把他放进一个字典里就好啦,具体操作见下面代码。

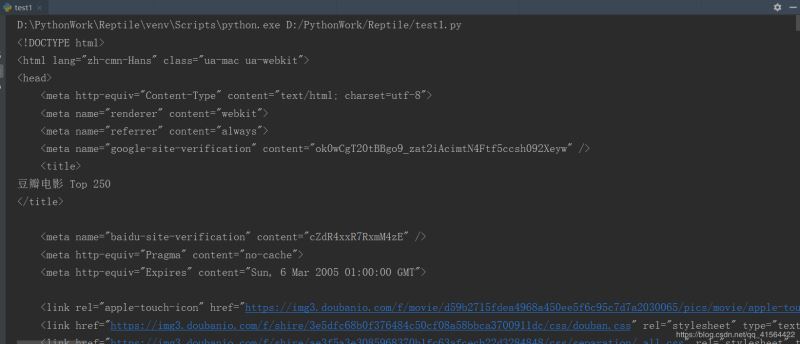

现在我们再来看部分输出结果。  我们可以发现已经将该网站的HTML文件全部爬取到了,至此第一种方法就将完成了。下面我们来看第二种方法。 (二) IP限制 IP(Internet Protocol) 全称互联网协议地址,意思是分配给用户上网使用的网际协议的设备的数字标签。它就像我们身份证号一样,只要知道你的身份证号就能查出你是哪个人。 当我们爬取大量数据时,如果我们不加以节制地访问目标网站,会使网站超负荷运转,一些个人小网站没什么反爬虫措施可能因此瘫痪。而大网站一般会限制你的访问频率,因为正常人是不会在 1s 内访问几十次甚至上百次网站的。所以,如果你访问过于频繁,即使改了 user-agent 伪装成浏览器了,也还是会被识别为爬虫,并限制你的 IP 访问该网站。 因此,我们常常使用 time.sleep() 来降低访问的频率,比如上一篇博客中的爬取整个网站的代码,我们每爬取一个网页就暂停一秒。

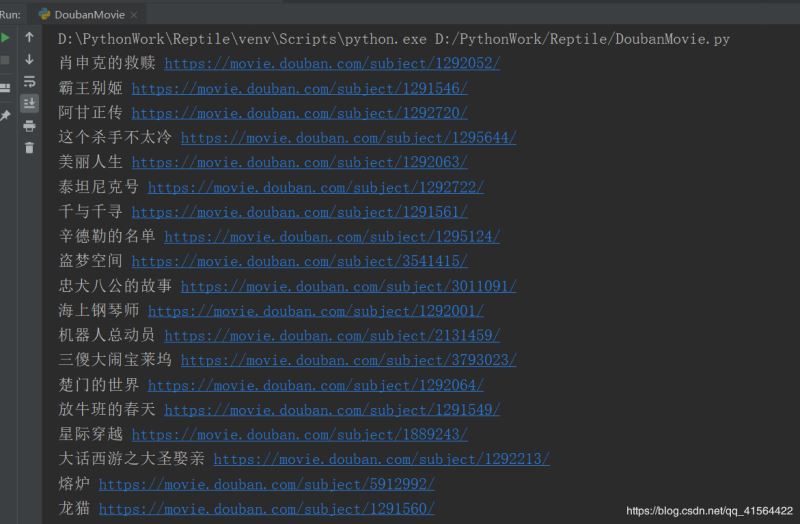

部分运行结果:  至此两种比较简单的应对反爬虫方法就讲完啦,希望能对大家有所帮助,如果有问题,请及时给予我指正,感激不尽! |

2019-06-18

2019-07-04

2021-05-23

2021-05-27

2021-05-27